Здравствуйте, уважаемые читатели блога сайт. Хочу сделать очередной заход на тему «сбора семядра». Сначала , как полагается, а потом много практики, может быть и несколько неуклюжей в моем исполнении. Итак, лирика. Ходить с завязанными глазами в поисках удачи мне надоело уже через год, после начала ведения этого блога. Да, были «удачные попадания» (интуитивное угадывание часто задаваемых поисковикам запросов) и был определенный трафик с поисковиков, но хотелось каждый раз бить в цель (по крайней мере, ее видеть).

Потом захотелось большего — автоматизации процесса сбора запросов и отсева «пустышек». По этой причине появился опыт работы с Кейколлектором (и его неблагозвучным младшим братом) и очередная статья на тему . Все было здорово и даже просто замечательно, пока я не понял, что есть один таки очень важный момент, оставшийся по сути за кадром — раскидывание запросов по статьям.

Писать отдельную статью под отдельный запрос оправдано либо в высококонкурентных тематиках, либо в сильно доходных. Для инфосайтов же — это полный бред, а посему приходится запросы объединять на одной странице. Как? Интуитивно, т.е. опять же вслепую. А ведь далеко не все запросы уживаются на одной странице и имеют хотя бы гипотетический шанс выйти в Топ.

Собственно, сегодня как раз и пойдет речь об автоматической кластеризации семантического ядра посредством KeyAssort (разбивке запросов по страницам, а для новых сайтов еще и построение на их основе структуры, т.е. разделов, категорий). Ну, и сам процесс сбора запросов мы еще раз пройдем на всякий пожарный (в том числе и с новыми инструментами).

Какой из этапов сбора семантического ядра самый важный?

Сам по себе сбор запросов (основы семантического ядра) для будущего или уже существующего сайта является процессом довольно таки интересным (кому как, конечно же) и реализован может быть несколькими способами, результаты которых можно будет потом объединить в один большой список (почистив дубли, удалив пустышки по стоп словам).

Например, можно вручную начать терзать Вордстат , а в добавок к этому подключить Кейколлектор (или его неблагозвучную бесплатную версию). Однако, это все здорово, когда вы с тематикой более-менее знакомы и знаете ключи, на которые можно опереться (собирая их производные и схожие запросы из правой колонки Вордстата).

В противном же случае (да, и в любом случае это не помешает) начать можно будет с инструментов «грубого помола». Например, Serpstat (в девичестве Prodvigator), который позволяет буквально «ограбить» ваших конкурентов на предмет используемых ими ключевых слов (смотрите ). Есть и другие подобные «грабящие конкурентов» сервисы (spywords, keys.so), но я «прикипел» именно к бывшему Продвигатору.

В конце концов, есть и бесплатный Букварис , который позволяет очень быстро стартануть в сборе запросов. Также можно заказать частным образом выгрузку из монстрообразной базы Ahrefs и получить опять таки ключи ваших конкурентов. Вообще, стоит рассматривать все, что может принести хотя бы толику полезных для будущего продвижения запросов, которые потом не так уж сложно будет почистить и объединить в один большой (зачастую даже огромный список).

Все это мы (в общих чертах, конечно же) рассмотрим чуть ниже, но в конце всегда встает главный вопрос — что делать дальше . На самом деле, страшно бывает даже просто подступиться к тому, что мы получили в результате (пограбив десяток-другой конкурентов и поскребя по сусекам Кейколлектором). Голова может лопнуть от попытки разбить все эти запросы (ключевые слова) по отдельным страницах будущего или уже существующего сайта.

Какие запросы будут удачно уживаться на одной странице, а какие даже не стоит пытаться объединять? Реально сложный вопрос, который я ранее решал чисто интуитивно, ибо анализировать выдачу Яндекса (или Гугла) на предмет «а как там у конкурентов» вручную убого, а варианты автоматизации под руку не попадались. Ну, до поры до времени. Все ж таки подобный инструмент «всплыл» и о нем сегодня пойдет речь в заключительной части статьи.

Это не онлайн-сервис, а программное решение, дистрибутив которого можно скачать на главной странице официального сайта (демо-версию).

Посему никаких ограничений на количество обрабатываемых запросов нет — сколько надо, столько и обрабатывайте (есть, однако, нюансы в сборе данных). Платная версия стоит менее двух тысяч, что для решаемых задач, можно сказать, даром (имхо).

Но про техническую сторону KeyAssort мы чуть ниже поговорим, а тут хотелось бы сказать про сам принцип, который позволяет разбить список ключевых слов (практически любой длины) на кластеры, т.е. набор ключевых слов, которые с успехом можно использовать на одной странице сайта (оптимизировать под них текст, заголовки и ссылочную массу — применить магию SEO).

Откуда вообще можно черпать информацию? Кто подскажет, что «выгорит», а что достоверно не сработает? Очевидно, что лучшим советчиком будет сама поисковая система (в нашем случае Яндекс, как кладезь коммерческих запросов). Достаточно посмотреть на большом объеме данных выдачу (допустим, проаналазировать ТОП 10) по всем этим запросам (из собранного списка будущего семядра) и понять, что удалось вашим конкурентам успешно объединить на одной странице. Если эта тенденция будет несколько раз повторяться, то можно говорить о закономерности, а на основе нее уже можно бить ключи на кластеры.

KeyAssort позволяет в настройках задавать «строгость», с которой будут формироваться кластеры (отбирать ключи, которые можно использовать на одной странице). Например, для коммерции имеет смысл ужесточать требования отбора, ибо важно получить гарантированный результат, пусть и за счет чуть больших затрат на написание текстов под большее число кластеров. Для информационных сайтов можно наоборот сделать некоторые послабления, чтобы меньшими усилиями получить потенциально больший трафик (с несколько большим риском «невыгорания»). Как это сделать опять же поговорим.

А что делать, если у вас уже есть сайт с кучей статей, но вы хотите расширить существующее семядро и оптимизировать уже имеющиеся статьи под большее число ключей, чтобы за минимум усилий (чуток сместить акцент ключей) получить поболе трафика? Эта программка и на этот вопрос дает ответ — можно те запросы, под которые уже оптимизированы существующие страницы, сделать маркерными, и вокруг них KeyAssort соберет кластер с дополнительными запросами, которые вполне успешно продвигают (на одной странице) ваши конкуренты по выдаче. Интересненько так получается...

Как собрать пул запросов по нужной вам тематике?

Любое семантическое ядро начинается, по сути, со сбора огромного количества запросов, большая часть из которых будет отброшена. Но главное, чтобы на первичном этапе в него попали те самые «жемчужины», под которые потом и будут создаваться и продвигаться отдельные страницы вашего будущего или уже существующего сайта. На данном этапе, наверное, самым важным является набрать как можно больше более-менее подходящих запросов и ничего не упустить, а пустышки потом легко отсеяться.

Встает справедливый вопрос, а какие инструменты для этого использовать ? Есть один однозначный и очень правильный ответ — разные. Чем больше, тем лучше. Однако, эти самые методики сбора семантического ядра, наверное, стоит перечислить и дать общие оценки и рекомендации по их использованию.

- Яндекс Вордстат

и его аналоги у других поисковых систем — изначально эти инструменты предназначались для тех, кто размещает контекстную рекламу, чтобы они могли понимать, насколько популярны те или иные фразы у пользователей поисковиков. Ну, понятно, что Сеошники этими инструментами пользуются тоже и весьма успешно. Могу порекомендовать пробежаться глазами по статье , а также упомянутой в самом начале этой публикации статье (полезно будет начинающим).

Из недостатков Водстата можно отметить:

- Чудовищно много ручной работы (однозначно требуется автоматизация и она будет рассмотрена чуть ниже), как по пробивке фраз основанных на ключе, так и по пробивке ассоциативных запросов из правой колонки.

- Ограничение выдачи Вордстата (2000 запросов и не строчкой больше) может стать проблемой, ибо для некоторых фраз (например, «работа») это крайне мало и мы упускаем из вида низкочастотные, а иногда даже и среднечастотные запросы, способные приносить неплохой трафик и доход (их ведь многие упускают). Приходится «сильно напрягать голову», либо использовать альтернативные методы (например, базы ключевых слов, одну из которых мы рассмотрим ниже — при этом она бесплатная!).

- КейКоллектор

(и его бесплатный младший брат Slovoeb

) — несколько лет назад появление этой программы было просто «спасением» для многих тружеников сети (да и сейчас представить без КК работу над семядром довольно трудно). Лирика. Я купил КК еще два или три года назад, но пользовался им от силы несколько месяцев, ибо программа привязана к железу (начинке компа), а она у меня по нескольку раз в год меняется. В общем, имея лицензию на КК пользуюсь SE — так то вот, до чего лень доводит.

Подробности можете почитать в статье « ». Обе программы помогут вам собрать запросы и из правой, и из левой колонки Вордстата, а также поисковые подсказки по нужным вам ключевым фразам. Подсказки — это то, что выпадает из поисковой строки, когда вы начинаете набирать запрос. Пользователи часто не закончив набор просто выбирают наиболее подходящий из этого списка вариант. Сеошники это дело просекли и используют такие запросы в оптимизации и даже .

КК и SE позволяют сразу набрать очень большой пул запросов (правда, может потребоваться много времени, либо покупка XML лимитов, но об этом чуть ниже) и легко отсеять пустышки, например, проверкой частотности фраз взятых в кавычки (учите матчасть, если не поняли о чем речь — ссылки в начале публикации) или задав список стоп-слов (особо актуально для коммерции). После чего весь пул запросов можно легко экспортировать в Эксель для дальнейшей работы или для загрузки в KeyAssort (кластеризатор), о котором речь пойдет ниже.

- СерпСтат

(и другие подобные сервисы) — позволяет введя Урл своего сайта получить список ваших конкурентов по выдаче Яндекса и Гугла. А по каждому из этих конкурентов можно будет получить полный список ключевых слов, по которым им удалось пробиться и достичь определенных высот (получить трафик с поисковиков). Сводная таблица будет содержать частотность фразы, место сайта по ней в Топе и кучу другой разной полезной и не очень информации.

Не так давно я пользовал почти самый дорогой тарифный план Серпстата (но только один месяц) и успел за это время насохранять в Экселе чуть ли не гигабайт разных полезняшек. Собрал не только ключи конкурентов, но и просто пулы запросов по интересовавшим меня ключевым фразам, а также собрал семядра самых удачных страниц своих конкурентов, что, мне кажется, тоже очень важно. Одно плохо — теперь никак время не найду, чтобы вплотную заняться обработкой всей это бесценной информации. Но возможно, что KeyAssort все-таки снимет оцепенение перед чудовищной махиной данных, которые нужно обработать.

- Букварикс

— бесплатная база ключевых слов в своей собственной программной оболочке. Подбор ключевиков занимает доли секунды (выгрузка в Эксель минуты). Сколько там миллионов слов не помню, но отзывы о ней (в том числе и мой) просто отличные, и главное все это богатство бесплатно! Правда, дистрибутив программы весить 28 Гигов, а в распокованном виде база занимает на жестком диске более 100 Гбайт, но это все мелочи по сравнению с простотой и скоростью сбора пула запросов.

Но не только скорость сбора семядра является основным плюсом по сравнению с Вордстатом и КейКоллектором. Главное, что тут нет ограничений на 2000 строк для каждого запроса, а значит никакие НЧ и сверх НЧ от нас не ускользнут. Конечно же, частотность можно будет еще раз уточнить через тот же КК и по стоп-словам в нем отсев провести, но основную задачу Букварикс выполняет замечательно. Правда, сортировка по столбцам у него не работает, но сохранив пул запросов в Эксель там можно будет сортировать как заблагороссудится.

Наверное, еще как минимум несколько «серьезных» инструментов собора пула запросов приведете вы сами в комментариях, а я их успешно позаимствую...

Как очистить собранные поисковые запросы от «пустышек» и «мусора»?

Полученный в результате описанных выше манипуляций список, скорее всего, будет весьма большим (если не огромным). Поэтому прежде чем загружать его в кластерезатор (у нас это будет KeyAssort) имеет смысл его слегка почистить . Для этого пул запросов, например, можно выгрузить к кейколлектор и убрать:

- Запросы со слишком низкой частотностью (лично я пробиваю частотность в кавычках, но без восклицательных знаков). Какой порог выбирать решать вам, и во многом это зависит от тематики, конкурентности и типа ресурса, под который собирается семядро.

- Для коммерческих запросов имеется смысл использовать список стоп-слов (типа, «бесплатно», «скачать», «реферат», а также, например, названия городов, года и т.п.), чтобы заранее убрать из семядра то, что заведомо не приведет на сайт целевых покупателей (отсеять халявшиков, ищущих информацию, а не товар, ну, и жителей других регионов, например).

- Иногда имеет смысл руководствоваться при отсеве показателем конкуренции по данному запросу в выдаче. Например, по запросу «пластиковые окна» или «кондиционеры» можно даже не рыпаться — провал обеспечен заранее и со стопроцентной гарантией.

Скажите, что это слишком просто на словах, но сложно на деле. А вот и нет. Почему? А потому что один уважаемый мною человек (Михаил Шакин) не пожалел времени и записал видео с подробным описанием способов очистки поисковых запросов в Key Collector :

Спасибо ему за это, ибо данные вопрос гораздо проще и понятнее показать, чем описать в статье. В общем справитесь, ибо я в вас верю...

Настройка кластеризатора семядра KeyAssort под ваш сайт

Собственно, начинается самое интересное. Теперь весь этот огромный список ключей нужно будет как-то разбить (раскидать) на отдельных страницах вашего будущего или уже существующего сайта (который вы хотите существенно улучшить в плане приносимого с поисковых систем трафика). Не буду повторяться и говорить о принципах и сложности данного процесса, ибо зачем тогда я первую часть этой стать писал.

Итак, наш метод довольно прост. Идем на официальный сайт KeyAssort и скачиваем демо-версию , чтобы попробовать программу на зуб (отличие демо от полной версии — это невозможность выгрузить, то бишь экспортировать собранное семядро), а уже опосля можно будет и оплатить (1900 рубликов — мало, мало по современным реалиям). Если хотите сразу начать работу над ядром что называется «на чистовик», то лучше тогда выбрать полную версию с возможностью экспорта.

Программа КейАссорт сама собирать ключи не умеет (это, собственно, и не ее прерогатива), а посему их потребуется в нее загрузить. Сделать это можно четырьмя способами — вручную (наверное, имеется смысл прибегать к этому методу для добавления каких-то найденных уже опосля основного сбора ключей), а также три пакетных способа импорта ключей :

- в формате тхт — когда нужно импортировать просто список ключей (каждый на отдельной строке тхт файлика и ).

- а также два варианта экселевского формата: с нужными вам в дальнейшем параметрами, либо с собранными сайтами из ТОП10 по каждому ключу. Последнее может ускорить процесс кластеризации, ибо программе KeyAssort не придется самой парсить выдачу для сбора эти данных. Однако, Урлы из ТОП10 должны быть свежими и точными (такой вариант списка можно получить, например, в Кейколлекторе).

Да, что я вам рассказываю — лучше один раз увидеть:

В любом случае, сначала не забудьте создать новый проект в том же самом меню «Файл», а уже потом только станет доступной функция импорта:

Давайте пробежимся по настройкам программы (благо их совсем немного), ибо для разных типов сайтов может оказаться оптимальным разный набор настроек. Открываете вкладку «Сервис» — «Настройки программы» и можно сразу переходить на вкладку «Кластеризация» :

Тут самое важное — это, пожалуй, выбор необходимого вам вида кластеризации . В программе могут использоваться два принципа, по которым запросы объединяются в группы (кластеры) — жесткий и мягкий.

- Hard — все запросы попавшие в одну группу (пригодные для продвижения на одной странице) должны быть объединены на одной странице у необходимого числа конкурентов из Топа (это число задается в строке «сила группировки»).

- Soft — все запросы попавшие в одну группу будут частично встречаться на одной странице у нужного числа конкурентов и Топа (это число тоже задается в строке «сила группировки»).

Есть хорошая картинка наглядно все это иллюстрирующая:

Если непонятно, то не берите в голову, ибо это просто объяснение принципа, а нам важна не теория, а практика, которая гласит, что:

- Hard кластеризацию лучше применять для коммерческих сайтов . Этот метод дает высокую точность, благодаря чему вероятность попадания в Топ объединенных на одной странице сайта запросов будет выше (при должном подходе к оптимизации текста и его продвижению), хотя самих запросов будет меньше в кластере, а значит самих кластеров больше (больше придется страниц создавать и продвигать).

- Soft кластеризацию имеет смысл использовать для информационных сайтов , ибо статьи будут получаться с высоким показателем полноты (будут способны дать ответ на ряд схожих по смыслу запросов пользователей), которая тоже учитывается в ранжировании. Да и самих страниц будет поменьше.

Еще одной важной, на мой взгляд, настройкой является галочка в поле «Использовать маркерные фразы» . Зачем это может понадобиться? Давайте посмотрим.

Допустим, что у вас уже есть сайт, но страницы на нем были оптимизированы не под пул запросов, а под какой-то один, или же этот пул вы считаете недостаточно объемным. При этом вы всем сердцем хотите расширить семядро не только за счет добавления новых страниц, но и за счет совершенствования уже существующих (это все же проще в плане реализации). Значит нужно для каждой такой страниц добрать семядро «до полного».

Именно для этого и нужна эта настройка. После ее активации напротив каждой фразы в вашем списке запросов можно будет поставить галочку. Вам останется только отыскать те основные запросы, под которые вы уже оптимизировали существующие страницы своего сайта (по одному на страницу) и программа KeyAssort выстроит кластеры именно вокруг них. Собственно, все. Подробнее в этом видео:

Еще одна важная (для правильной работы программы) настройка живет на вкладке «Сбор данных с Яндекс XML» . вы можете прочитать в приведенной статье. Если вкратце, то Сеошники постоянно парсят выдачу Яндекса и выдачу Вордстата, создавая чрезмерную нагрузку на его мощности. Для защиты была внедрена капча, а также разработан спецдоступ по XML, где уже не будет вылезать капча и не будет происходить искажение данных по проверяемым ключам. Правда, число таких проверок в сутки будет строго ограничено.

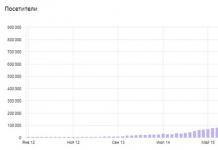

От чего зависит число выделенных лимитов? От того, как Яндекс оценит ваши . можно перейдя по этой ссылке (находясь в том же браузере, где вы авторизованы в Я.Вебмастере). Например, у меня это выглядит так:

Там еще есть снизу график распределения лимитов по времени суток, что тоже важно. Если запросов нужно пробить много, а лимитов мало, то не проблема. Их можно докупить . Не у Яндекса, конечно же, напрямую, а у тех, у кого эти лимиты есть, но они им не нужны.

Механизм Яндекс XML позволяет проводить передачу лимитов, а биржи, подвязавшиеся быть посредниками, помогают все это автоматизировать. Например, на XMLProxy можно прикупить лимитов всего лишь по 5 рублей за 1000 запросов, что, согласитесь, совсем уж не дорого.

Но не суть важно, ибо купленные вами лимиты все равно ведь перетекут к вам на «счет», а вот чтобы их использовать в KeyAssort, нужно будет перейти на вкладку "Настройка " и скопировать длинную ссылку в поле «URL для запросов» (не забудьте кликнуть по «Ваш текущий IP» и нажать на кнопку «Сохранить», чтобы привязать ключ к вашему компу):

После чего останется только вставить этот Урл в окно с настройками KeyAssort в поле «Урл для запросов»:

Собственно все, с настройками KeyAssort покончено — можно приступать к кластеризации семантического ядра.

Кластеризация ключевых фраз в KeyAssort

Итак, надеюсь, что вы все настроили (выбрали нужный тип кластеризации, подключили свои или покупные лимиты от Яндекс XML), разобрались со способами импорта списка с запросами, ну и успешно все это дело перенесли в КейАссорт. Что дальше? А дальше уж точно самое интересное — запуск сбора данных (Урлов сайтов из Топ10 по каждому запросу) и последующая кластеризация всего списка на основе этих данных и сделанных вами настроек.

Итак, для начала жмем на кнопку «Собрать данные» и ожидаем от нескольких минут до нескольких часов, пока программа прошерстит Топы по всем запросам из списка (чем их больше, тем дольше ждать):

У меня на три сотни запросов (это маленькое ядро для серии статей про работу в интернете) ушло около минуты. После чего можно уже приступать непосредственно к кластеризации , становится доступна одноименная кнопка на панели инструментов KeyAssort. Процесс этот очень быстрый, и буквально через несколько секунд я получил целый набор калстеров (групп), оформленных в виде вложенных списков:

Подробнее об использовании интерфейса программы, а также про создание кластеров для уже существующих страниц сайта смотрите лучше в ролике, ибо так гораздо нагляднее:

Все, что хотели, то мы и получили, и заметьте — на полном автомате. Лепота.

Хотя, если вы создаете новый сайт, то кроме кластеризации очень важно бывает наметить будущую структуру сайта (определить разделы/категории и распределить по ним кластеры для будущих страниц). Как ни странно, но это вполне удобно делать именно в KeyAssort, но правда уже не в автоматическом режиме, а в ручном режиме. Как?

Проще опять же будет один раз увидеть — все верстается буквально на глазах простым перетаскиванием кластеров из левого окна программы в правое:

Если программу вы таки купили, то сможете экспортировать полученное семантическое ядро (а фактически структуру будущего сайта) в Эксель. Причем, на первой вкладке с запросами можно будет работать в виде единого списка, а на второй уже будет сохранена та структура, что вы настроили в KeyAssort. Весьма, весьма удобно.

Ну, как бы все. Готов обсудить и услышать ваше мнение по поводу сбора семядра для сайта.

Удачи вам! До скорых встреч на страницах блога сайт

Вам может быть интересно

Vpodskazke - новый сервис Вподсказке для продвижения подсказок в поисковых системах

SE Ranking - лучший сервис мониторинга позиций для новичков и профессионалов в SEO

Сбор полного семантического ядра в Топвизоре, многообразие способов подбора ключевых слов и их группировка по страницам

Практика сбора семантического ядра под SEO от профессионала - как это происходит в текущих реалиях 2018

Оптимизация поведенческих факторов без их накрутки

SEO PowerSuite - программы для внутренней (WebSite Auditor, Rank Tracker) и внешней (SEO SpyGlass, LinkAssistant) оптимизации сайта

SERPClick: продвижение поведенческими факторами

SERPClick: продвижение поведенческими факторами

Михаил (Kashchey)

18.11.2015

Семантическое ядро сайта: что это такое? Сбор семантического ядра и анализ ключевых запросов

Что такое семантическое ядро (СЯ)? Перед тем, как я дам ответы, давайте разберёмся со смежными понятиями. Это нужно, чтобы мы говорили на одном языке. Итак:

Ключевой запрос (КЗ) – это фраза, которую вбивают в строку поиска Яндекса, Google и т. д.

Частотность запросов. Есть низкочастотные, среднечастотные и высокочастотные категории запросов (НЧ, СЧ, ВЧ)

Целевая аудитория (ЦА) . Те, кому интересны ваши услуги, товары или информация.

Что такое СЯ? СЯ – это совокупность ключевых запросов всех категорий, по которым на ваш сайт будет приходить ваша целевая аудитория. Как-то так. Второй вопрос, который нужно рассмотреть до того, как перейти к составлению семантического ядра, точнее к рассказу о том, как составить семантическое ядро, — это частотность ключевых запросов. Что это и как разделить запросы по частоте?

Разделить запросы по частоте несложно. Если ключ вбивают более 1000 раз в месяц, то это однозначно ВЧ. Если 100-1000, то это СЧ. Всё, что меньше 100 – это НЧ.

Внимание! В некоторых узких тематиках эти цифры не работают. То есть вам нужно найти самый высокочастотный запрос – это и будет ВЧ. Среднечастотные запросы будут между НЧ и ВЧ. Какие сервисы помогают узнать, сколько людей вбивают эту ключевую фразу ежемесячно? Ответ ищите в статье: (в этой статье вы найдёте информацию и о SEO-сервисах, которые помогают подобрать КЗ)

Теперь, когда я попытался объяснить, что есть что, приступаем к главному: к сбору семантического ядра.

Составление семантического ядра для сайта

Составить семантическое ядро не так просто, как кажется. Вам нужно учесть все возможные варианты НЧ и СЧ запросов. Для составления SEO-ядра лучше воспользоваться пециальными сервисами. Информацию о них можно найти по ссылке выше.

Как подбирать запросы? Представим, что вы создаёте сайт для любителей кошек. Как бы вы стали искать информацию о кошках? Чтобы вы написали в поиск? Первое, что придёт в голову. Например:

Кошка (ВЧ+) (кошки – это не отдельный запрос)

Сиамский кот (ВЧ)

Кошаки (СЧ)

Что едят домашние кошки (НЧ)

Частотность я проверял на сервисе wordstat.yandex.ru. Вот так:

Обратите внимание на кавычки. Они нужны, чтобы узнать, сколько людей вводили запрос в прямом вхождении. При составлении семантического нужно ориентироваться на прямые запросы и «хвосты». О «хвостах» можно почитать .

Надеюсь, что это понятно.

Найти все возможные тематически ключи – это муторная, кропотливая работа, которая отнимает много времени. Однако от качества сборки семантического ядра сайта зависит очень многое – успех дальнейшей SEO-оптимизации ресурса.

Что самое главное при составлении СЯ?

Самое важное при составлении семантического ядра – это грамотно структурировать все ключевые запросы. Это нужно, чтобы использовать составленное семантическое ядро максимально эффективно. И нет ничего лучше, чем таблица.

Вот удачный пример таблицы. К слову… таблицу лучше делать в программе Exel.

Итак, что мы видим? Мы видим грамотную структуру, по ней легко работать. Вы можете дополнить таблицу своими колонками, чтобы облегчить свою задачу.

Ваша задача найти как можно больше НЧ запросов с низкой конкуренцией и продвигать свой сайт по этим запросам. Как определить, что запрос низкоконкурентный? Если запрос НЧ, то в 80% случаев у него маленькая конкуренция. Проверить уровень конкуренции можно и в поисковике. Вот так:

Результат: 43 миллиона ответов. Конкуренция для темы кошек будет низкая. Для других тем нужно ориентироваться на другие цифры. Например, КЗ «копирайтер» — это ВЧ ключ с 2 миллионами ответов, и он имеет высокую конкуренцию.

В статьи под НЧ запросы автоматически будут вписываться ВЧ запросы – это нормально. Лучше всего писать одну статью на один КЗ, подбирать к ней картинку и прогонять её по группам в социальных сетях + продвигать её статьями со ссылкой, но это долго и накладно. Поэтому в статью включают 2-3 ключа – это позволяет сократить расходы на статьи.

Статья не ответила на ваш вопрос? Так задайте его в комментариях!

P.S. мне будет приятно.

Семантическое ядро (сокращенно СЯ) - это определенный список ключевых слов, которые максимально описывают тематику сайта.

Зачем нужно составлять семантическое ядро сайта

- семантическое ядро характеризует , именно благодаря ему индексирующие страницу роботы определяют не только естественность текста, но и тематику, чтобы внести страницу в соответствующий поисковый раздел. Очевидно, что роботы работают на полной автономии после введения адреса страницы сайта в базу поисковых ресурсов;

- грамотно составленное ся является смысловой основой сайта и отражает подходящую структуру для сео-продвижения;

- каждая страница сайта, соответственно, привязывается к определенной части СЯ веб-ресурса;

- благодаря семантическому ядру формируется стратегия продвижения в поисковиках;

- по семантическому ядру можно оценить во сколько обойдется продвижение.

Основные правила составления семантического ядра

Чтобы собрать СЯ, потребуется собрать наборы ключевых слов. В этом отношении нужно оценивать свои силы относительно продвижения по высоко- и среднечастотным запросам. Если требуется получить максимум посетителей при наличии бюджета, нужно использовать высоко- и среднечастотные запросы. Если наоборот, то средне- и низкочастотные запросы.

Даже при наличии высокого бюджета нет смысла продвигать сайт только по высокочастотным запросам. Часто такие запросы имеют слишком общий характер и неконкретизированную смысловую нагрузку, например «слушать музыку», «новости», «спорт».

При выборе поисковых запросов анализируют множество показателей, которые соответствуют поисковому словосочетанию:

- количество показов (частота);

- количество показов без морфологического изменений и словосочетаний;

- страницы, которые выдаются поисковой системой при введении поискового запроса;

- страницы в поисковом ТОП-е по ключевым запросам;

- оценка стоимости продвижения по запросу;

- конкурентность ключевых слов;

- прогнозируемое количество переходов;

- показатель отказов (закрытие сайта после перехода по ссылке) и сезонность услуги;

- геозависимость ключевого слова (географическое расположение компании и ее клиентов).

Как можно собрать семантическое ядро

На практике подбор семантического ядра можно провести следующими методами:

Источником ключевых слов для семантического ядра могут стать сайты конкурентов. Именно здесь можно быстро подобрать ключевые слова, а также определить частотность их «окружения» с помощью семантического анализа. Для этого потребуется сделать семантическую оценку страницы текста, наиболее упоминаемые слова составляют морфологическое ядро;

Рекомендуем сформировать собственное семантическое ядро на базе статистики специальных сервисов. Воспользуйтесь, например, Wordstat Yandex – статистической системой поисковой системы Yandex. Здесь можно посмотреть частотность поискового запроса, а также узнать, что пользователи ищут вместе с этим ключевым словом;

«Подсказки» систем появляются при попытке введения поисковой фразы в интерактивную строку. Эти слова и словосочетания могут также войти в СЯ как связные;

Источником ключевых слов для СЯ могут стать закрытые базы данных поисковых запросов, например, база Пастухова. Это специальные массивы данных, содержащие информацию об эффективных сочетаниях поисковых запросов;

Внутренняя статистика сайта также может стать источником данных об интересующих пользователя поисковых запросах. Она содержит информацию об источнике и знает, откуда пришел читатель, сколько страниц просмотрел и с какого браузера он заходил.

Бесплатные инструменты для составления семантического ядра:

Yandex.Wordstat - популярный бесплатный инструмент, используемый при составлении семантического ядра. С помощью сервиса можно узнать, какое количество раз посетители ввели в поисковую систему Yandex определенный запрос. Предоставляет возможность проанализировать динамику спроса на данный запрос по месяцам.

Google AdWords относится к числу наиболее используемых систем для оставления семантического ядра сайта. С помощью планировщика ключевых слов от Гугла можно просчитать и составить прогноз показов конкретных запросов в дальнейшем.

Яндекс.Директ многие разработчики используют для подбора максимально выгодные ключевые слова. Если в дальнейшем на сайте планируется размещение рекламных объявлений, то владелец ресурса при таком подходе получит неплохую прибыль.

Словоеб - младший брат Кей Коллектора, который применяется для составления семантического ядра сайта. За основу берутся данные из Яндекса. Из преимуществ можно отметить интуитивно понятный интерфейс, а также доступность не только для профессионалов, но и для новичков, которые только начинают заниматься SEO аналитикой.

Платные инструменты для составления семантического ядра:

Базы Пастухова по мнению многих специалистов не имеют конкурентов. В базе отображаются такие запросы, которые не показывает ни Гугл, ни Яндекс. Существует много других особенностей, присущих именно базам Макса Пастухова, среди которых можно отметить удобную программную оболочку.

SpyWords - интересный инструмент, позволяющий анализировать ключевые слова конкурентов. С его помощью можно провести сравнительный анализ семантических ядер интересующих ресурсов, а также получить все данные о РРС и SEO компаниях конкурентов. Ресурс русскоязычный, разобраться с его функционалом не составит никаких проблем.

Платная программа, созданная специально для профессионалов. Помогает составлять семантическое ядро, определяя актуальные запросы. Используется для оценки стоимости продвижения ресурса по интересующим ключевым словам. Помимо высокого уровня эффективности, данная программа выгодно отличается удобством в использовании.

SEMrush позволяет на основании данных с конкурирующих ресурсов определить наиболее результативные ключевые слова. С его помощью можно подобрать низкочастотные запросы, характеризующиеся высоким уровнем трафика. Как показывает практика, по таким запросам очень легко продвинуть ресурс на первые позиции выдачи.

SeoLib - сервис, завоевавший доверие со стороны оптимизаторов. Обладает достаточно большим функционалом. Позволяет грамотно составить семантическое ядро, а также выполнить необходимые аналитические мероприятия. В бесплатном режиме можно проанализировать 25 запросов в сутки.

Prodvigator позволяет собрать первичное семантическое ядро буквально за несколько минут. Это сервис используемый главным образом для анализа конкурирующих сайтов, а также для подбора наиболее результативных ключевых запросов. Анализ слов выбирается для Google по России или для Яндекса по Московскому региону.

Семантическое ядро собирается достаточно быстро, если использовать источники и базы данных в качестве подсказки.

Следует выделить следующие процессы

Согласно содержанию сайта и релевантных тем выбираются ключевые запросы, которые наиболее точно отражают смысловую нагрузку вашего веб-портала.

- Из выбранного набора отсеиваются лишние, возможно, те запросы, которые могут ухудшить индексацию ресурса. Фильтрация ключевых слов проводится на основании результатов анализа, описанного выше.

- Полученное семантическое ядро должно быть равномерно распределено между страницами сайта, при необходимости заказываются тексты с определенной тематикой и объемом вхождения ключевых слов.

Пример сбора семантического ядра с помощью сервиса Wordstat Yandex

Например, вы продвигаете салон ногтевого сервиса в Москве.

Думаем и подбираем всевозможные слова, которые подходят теме сайта.

Деятельность компании

- салон маникюра;

- салон ногтевого сервиса;

- студия ногтевого сервиса;

- студия маникюра;

- студия педикюра;

- студия ногтевого дизайна.

Общее название услуг

Педикюр;

- маникюр;

- наращивание ногтей.

Теперь заходим на сервис Яндекса и вводим каждый запрос, предварительно выбрав регион, по которому собираемся продвигаться.

Копируем все слова в Excel из левой колонки, плюс вспомогательные фразы из правой.

Удаляем лишние слова, которые не подходят под тематику. Ниже красным выделены слова, которые подходят.

Цифра 2320 запросов показывает, сколько раз люди набирали этот запрос не только в чистом виде, но и в составе других словосочетаний. Например: маникюр и цена в москве, цена на маникюр и педикюр в москве и т.д.

Если ввести наш запрос в кавычках, то здесь уже будет другая цифра, где учитываются словоформы ключевой фразы. например: маникюр цены, маникюр цену и т.д.

Если ввести тот же запрос запрос в кавычках с восклицательными знаками, то увидим сколько раз пользователи набирали запрос именно "маникюр цена".

Далее делаем разбивку полученного списка слов по страницам сайта. Так, например, высокочастотные запросы мы оставим на главной странице и на основных разделах сайта, такие как: маникюр, студия ногтевого сервиса, наращивание ногтей. Средне- и низкочастотные распределим по остальным страницам, например: маникюр и педикюр цены, наращивание ногтей гелем дизайн. Слова также должны быть разделены на группы по смыслу.

- Главная страница - студия, салон ногтевого сервиса и т.д.

- 3 раздела - педикюр, маникюр, цены на маникюр и педикюр.

- Страницы - наращивание ногтей, аппаратный педикюр и т.д.

Какие ошибки можно допустить при составлении СЯ

При составлении семантического ядра никто не застрахован от ошибок. К наиболее распространенным относятся следующие:

- Всегда есть опасность выбора неэффективных запросов, которые дают минимальное количество посетителей.

- При повторной раскрутке сайта не стоит менять полностью контент, размещенный на сайте. В противном случае будут обнулены все предыдущие параметры, в том числе, ранжирование в поисковой выдаче.

- Не стоит использовать некорректные для русского языка запросы, поисковые роботы уже хорошо определяют такие запросы и при «спаме» ключевыми словами убирают страницу из поиска.

Желаем удачи в продвижении вашего сайта!

(11 )

В этом посте мы расскажем полный алгоритм сбора семантического ядра преимущественно для информационного сайта, но данный подход можно применять и для коммерческих сайтов.

Первоначальная семантика и создание структуры сайта

Подготовка слов для парсинга и первоначальная структура сайта

Перед тем как начать парсить слова, нам надо знать их. Поэтому нам надо составить первоначальную структуру нашего сайта и начальные слова для парсинга (их еще называют маркерами).

Первоначальную структуру и слова вы можете посмотреть:

1. Используя логику, слова из головы (если вы понимаете в теме).

2. У своих конкурентов, которых вы проанализировали при выборе ниш или введя ваш основной запрос.

3. Из википедии. Обычно это выглядит вот так:

4. Смотрим wordstat по вашим основным запросам и правую колонку.

5. Другие тематические книги и справочники.

Например, тема нашего сайта – болезни сердца. Понятно, что у нас в структуре обязательно должны быть все болезни сердца.

Вам не обойтись без медицинского справочника. Я бы не стал смотреть конкурентов, потому что у них могут быть представлены не все заболевания, скорее всего они не успели их охватить.

И ваши начальные слова для парсинга будут именно все болезни сердца, а уже исходя из ключей, которые мы напарсим, вы будете строить структуру сайта, когда начнете их группировать.

К тому же вы можете взять все препараты для лечения сердца, как расширение темы и т.д. Вы смотрите википедию, рубрики у конкурентов на сайте, wordstat, думаете логически и таким способом находите еще маркерные слова, которые будете парсить.

Структура сайта

Вы можете смотреть конкурентов для общего ознакомления, но не всегда вы должны делать структуру как у них. Вы должны исходить в большей степени из логики вашей целевой аудитории, они же вводят запросы, которые вы парсите у поисковиков.

Например, как поступить? Перечислить все болезни сердца, а от них уже вести симптомы, лечение. Или все-таки сделать рубрики симптомы, лечение, а от них уже вести болезни. Эти вопросы обычно решаются при группировке ключевых слов исходя из данных поисковых систем. Но не всегда, иногда вам придется делать выбор самостоятельно и решать, как сделать структуру наилучшей, потому что запросы могут пересекаться.

Вы должны всегда помнить, что структура создается на протяжении всего сбора семантики и иногда в первоначальном виде она состоит из нескольких рубрик, а уже при дальнейшей группировке и сборе она расширяется, так как вы начинаете видеть запросы и логику. А иногда вы сможете её составить и сразу не парся ключевые слова, потому что знаете хорошо тематику или она отлично представлена у конкурентов. Никакой системы по составлению структуры сайта нет, можно сказать это лично ваше творчество.

Структура может быть вашей индивидуальной (отличающейся от конкурентов), но обязательно она должна быть удобной для людей, отвечать их логике, а значит логике и поисковых систем и такой, чтобы можно было охватить все тематические слова в вашей нише. Она должна быть лучшей и удобной!

Думайте наперед. Бывает такое что берете нишу, а потом вам охота ее расширить, и вы начинаете менять структуру всего сайта. А созданную структуру на сайте, очень сложно и муторно менять. В идеале вам надо будет поменять урлы вложения и все это переклеить на самом сайте. Короче, это жесть какая нудная и очень ответственная работа, так что сразу определяйтесь окончательно по мужски, что и как у вас должно быть!

Если вы очень плохо знакомы с тематикой создаваемого сайта и не знаете, как будет строиться структура, не знаете какие начальные слова для парсинга взять, то 1 и 2 этап сбора вы можете менять местами. То есть сначала пропарсить конкурентов (как их парсить разберем ниже), посмотреть их ключи, на основе этого составить структуру и начальные слова для парсинга, а потом уже парсить wordstat, подсказки и т.д.

Для составления структуры я использую майнд менеджер - Xmind . Он бесплатен и в нем есть все основное.

Простенькая структура выглядит вот так:

Это структура коммерческого сайта. Обычно в информационных сайтах нет пересечений и всяких фильтров карточек товаров. Но и эта структура не сложная, составлялась для клиента, чтобы он понял. Обычно мои структуры состоят из множество стрелок и пересечений, комментариев - в такой структуре могу разобраться только я сам.

Можно ли создавать семантику по ходу наполнения сайта?

Если семантика легкая, вы уверены в теме и знаете её, то можно делать семантику параллельно с наполнением сайта. Но первоначальную структуру надо накидать обязательно. Я сам иногда такое практикую в очень узких нишах или в очень широких, чтобы не тратить много времени на сбор семантики, а сразу запускать сайт, но всё-таки не советовал бы так делать. Вероятность ошибок очень большая, если у вас нет опыта. Все-таки легче, когда вся семантика готова, вся структура готова и все разгруппировано и понятно. К тому же в готовой семантике вы видите каким ключам надо уделить первостепенное внимание, которые не имеют конкуренцию и принесут больше посетителей.

Еще здесь надо отталкивать от размера сайта, если ниша широкая, то нет смысла собирать семантику, лучше ее делать по ходу, потому что на сбор семантике может уйти месяц и более.

Так вот мы накидали первоначально структуру или не накидали, решили идти вторым этапом. У нас есть список начальных слов или фраз нашей тематики, которые мы можем начать парсить.

Парсинг и работа в keycollector

Для парсинга конечно же использую keycollector . Я не буду останавливаться на настройке keycollectora, вы можете почитать хелп этой программы или найти статьи по настройке в интернете, их очень много и там все подробно расписано.

При выборе источников парсинга стоит рассчитывать свои трудозатраты и их эффективность. Например, если вы будете парсить базу Пастухова или MOAB, то вы закапаетесь в куче мусорных запросов, которые надо будет отсеивать, а это время. И по моему мнению, это того не стоит, чтобы найти парочку каких-то запросиков. На тему баз есть очень интересное исследование от RushAnalytics, конечно же они там хвалят себя, но если на это не обращать внимание, весьма интересные данные по процентам плохих ключевых слов http://www.rush-analytics.ru/blog/analytica-istochnikov-semantiki

На первом этапе я парщу wordstat, adwords, их подсказки и использую базу ключевых слов Букварикс (десктопная версия бесплатна). Так же раньше просматривал подсказки из Youtube вручную. Но недавно keycollector добавил возможность их парсить, и это прелестно. Если вы полный извращенец, то можете сюда добавить другие базы ключевых слов.

Запускаете парсинг и понеслось.

Чистка семантического ядра для информационного сайта

Мы спарсили запросы и у нас получился список различных слов. В нем конечно же присутствуют нужные слова, а так же и мусорные – пустые, не тематические, не актуальные и т.д. Поэтому их надо почистить.

Ненужные слова я не удаляю, а перемещаю их в группы, потому что:

- Они в дальнейшем могут стать пищей для размышления и приобрести актуальность.

- Исключаем вероятность случайного удаления слов.

- При парсинге или добавление новых фраз, они не будут добавляться, если поставить галочку.

Я иногда забывал её ставить, поэтому настраиваю парсинг в одной группе и парсю ключи только в ней, чтобы сбор не дублировался:

Вы можете работать так или так, кому как удобно.

Сбор частотностей

Собираем у всех слов через direct, базовую частотность [W] и точную [“!W”].

Все что не собралось, дособираем через wordstat.

Чистка однословников и не формат

Фильтруем по однословникам, смотрим их и убираем не нужные. Есть такие однословники по которым нет смысла продвигаться, они не однозначные или дублируют другой однословный запрос.

Например, у нас тематика - болезни сердца. По слову “сердце” нет смысла продвигаться, не понятно, что человек имеет ввиду - это слишком широкий и неоднозначный запрос.

Так же смотрим, по каким словам не собралась частотность – это либо в словах содержатся спец символы, либо слов в запросе более 7. Переносим их в неформат. Малая вероятность что такие запросы вводят люди.

Чистка по общей и точной частотности

Все слова с общей частотностью [W] от 0 до 1 убираем.

Так же убираю и все от 0 до 1 по точной частотностью [”!W”].

Разношу их по разным группам.![]()

В дальнейшем в этих словах можно найти нормальные логические ключевые слова. Если ядро маленькое, то можно сразу вручную все слова с нулевой частотностью пересмотреть и оставить, которые как вам кажется вводят люди. Это поможет охватить тематику полностью и возможно, по таким словам будут переходить люди. Но естественно эти слова надо использовать в последнюю очередь, потому что по ним большого трафика точно не будет.

Значение от 0 до 1 тоже берется исходя от тематики, если ключевых слов много, то можно фильтровать и от 0 до 10. То есть все зависит от широты вашей тематики и ваших предпочтений.

Чистка по полноте охвата

Теория здесь такова: например, есть слово – “форум”, его базовая частотность составляет 8 136 416, а точная частотность 24 377, как видим отличие более чем в 300 раз. Поэтому можно предположить, что данный запрос пустой, он включает очень много хвостов.

Поэтому, по всем словам, я рассчитываю, такое KEI:

Точная частотность / Базовая частотность * 100% = полнота охвата

Чем меньше процент, тем больше вероятность что слово пустое.

В KeyCollector эта формула выглядит вот так:

YandexWordstatQuotePointFreq / (YandexWordstatBaseFreq+0.01) * 100

Здесь тоже все зависит от тематики и количества фраз в ядре, поэтому можно убирать полноту охвата меньше 5%. А где ядро большое то можно не брать и 10-30%.

Чистка по неявным дублям

Чтобы почистить неявные дубли, нам необходимо по ним собрать частотность Adwords и ориентироваться по ней, потому что она учитывает порядок слов. Экономим ресурсы, поэтому будем собирать этот показатель не у всего ядра, а только у дублей.

Таким способом мы нашли и отметили все не явные дубли. Закрываем вкладку - Анализ неявных дублей. Они у нас отметились в рабочей группе. Теперь отобразим только их, потому что съем параметров происходит только тех фраз, которые у нас показаны в группе на данный момент. И только потом запускаем парсинг.

Ждем, когда Adwords снимет показатели и заходим в анализ неявных дублей.

Выставляем вот такие параметры умной групповой отметки и нажимаем – выполнить умную проверку. Таким способом у нас в группе дублей не отметятся только самые высокочастотные запросы по Adwords.

Все дубли лучше конечно еще пробежаться и глянуть вручную, вдруг там что-то выставилось не так. Особенно уделить внимание группам, где нет показателей частотности, там дубли отмечаются случайно.

Все что вы отмечаете в анализе неявных группах, это проставляется и в рабочей группе. Так что после завершения анализа, просто закрываете вкладку и переносите все отмеченные неявные дубли в соответствующую папку.

Чистка по стоп словам

Стоп слова я тоже делю на группы. Отдельно заношу города. Они могут пригодится в дальнейшем, если мы надумаем делать каталог организаций.

Отдельно заношу слова содержащие в себе слова фото, видео. Вдруг они когда-нибудь пригодятся.

А так же, “витальные запросы”, например википедия, отношу сюда и форум, а так же в мед теме сюда могут относится – малышева, комаров и т.д.

Все так же зависит от тематики. Можно еще делать отдельно и коммерческие запросы – цена, купить, магазин.

Получается вот такой список групп по стоп словам:

Чистка накрученных слов

Это касается конкурентных тематик, их частенько накручивают конкуренты, чтобы ввести вас в заблуждение. Поэтому необходимо собрать сезонность и отсеять все слова с медианой равной 0.

А так же, можно глянуть соотношение базовой частотности к средней, большая разница может тоже указывать на накрутку запроса.

Но надо понимать, что эти показатели могут говорить и о том, что это новые слова по которым только недавно появилась статистика или они просто сезонные.

Чистка по гео

Обычно проверка по гео для информационных сайтов не требуется, но на всякий случай распишу этот момент.

Если есть сомнения, что часть запросов геозависимые, то лучше это проверить через сбор Rookee, он хоть бывает и ошибается, но намного реже чем проверка этого параметра по Яндексу. Потом после сбора Rookee стоит проверить все слова вручную, которые указались как геозависимые.

Ручная чистка

Теперь наше ядро стало в несколько раз меньше. Пересматриваем его в ручную и убираем ненужные фразы.

На выходе получаем вот такие группы нашего ядра:

Желтый - стоит покопаться, можно найти слова на будущее.

Оранжевый - могут пригодиться, если будем расширять сайт новыми сервисами.

Красный - не пригодятся.

Анализ конкуренции запросов для информационных сайтов

Собрав запросы и почистив их теперь нам надо проверить их конкуренцию, чтобы понимать в дальнейшем - какими запросами надо заниматься в первую очередь.

Конкуренция по количеству документов, title, главных страниц

Это все легко снимается через KEI в KeyCollector.

Получаем данные по каждому запросу, сколько документов найдено в поисковой системе, в нашем пример в Яндексе. Сколько главных страниц в выдаче по этому запросу и вхождений запроса в заголовок.

В интернете можно встретить различные формулы расчета этих показателей, даже вроде в свежем установленном KeyCollector по стандарту встроена какая-то формула расчета KEI. Но я им не следую, потому что надо понимать что каждый из этих факторов имеет разный вес. Например, самый главный, это наличие главных страниц в выдаче, потом уже заголовки и количество документов. Навряд ли эту важность факторов, как то можно учесть в формуле и если все-таки можно то без математика не обойтись, но тогда уже эта формула не сможет вписаться в возможности KeyCollector.

Конкуренция по биржам ссылок

Здесь уже интереснее. У каждой биржи свои алгоритмы расчета конкуренции и можно предположить, что они учитывают не только наличие главных страниц в выдаче, но и возраст страниц, ссылочную массу и другие параметры. В основном эти биржи конечно же рассчитаны на коммерческие запросы, но все равно более менее какие то выводы можно сделать и по информационным запросам.

Собираем данные по биржам и выводим средние показатели и уже ориентируемся по ним.

Я обычно собираю по 2-3 биржам. Главное чтобы все запросы были собраны по одним и тем же биржам и выведено среднее число только по ним. А не так, что какие то запросы собрали одними биржами, а другие другими и вывели среднее.

Для более наглядного вида можно применить формулу KEI, которая покажет стоимость одного посетителя исходя из параметров бирж:

KEI = AverageBudget / (AverageTraffic +0.01)

Средний бюджет по биржам делить на средний прогноз трафика по биржам, получаем стоимость одного посетителя исходя из данных бирж.

Конкуренция по мутаген

Его нет в keycollector, но это не помеха. Без проблем все слова можно выгрузить в Excel, а потом прогнать через KeyCollector.

Чем же лучше Keyso? У него больше база по сравнению с конкурентами. Она у него чистая, нет фраз которые дублируются и пишутся в разном порядке. Например, вы не найдете там таких повторяющихся ключей “диабет 1 типа”, “1 типа диабет”.

Так же Keyso умеет палить сайты с одним счетчиком Adsense, Analytics, Leadia и др. Вы можете увидеть какие еще есть сайты, у владельца анализируемого сайта. Да, и вообще по поиску сайтов конкурентов, считаю это лучшее решение.

Как работать с Keyso?

Берем один любой сайт своего конкурента, лучше конечно побольше, но не особо критично. Потому что мы будем работать в две итерации.Вводим его в поле. Жмакаем - анализировать.

Получаем информацию по сайту, нам здесь интересны конкуренты, жмем открыть всех.

У нас открываются все конкуренты.

Это все сайты, у которых хоть как-то пересекаются ключевые слова с нашим анализируемым сайтом. Здесь будет youtube.com, otvet.mail.ru и т.д., то есть крупные порталы, которые пишут обо всем подряд. Нам они не нужны, нам нужны сайты чисто только по нашей тематике. Поэтому мы их фильтруем по следующим критериям.

Похожесть – процент общих ключей от общего числа данного домена.

Тематичность – количество ключей нашего анализируемого сайта в ключах домена конкурента.

Поэтому пересечение этих параметров уберет общие сайты.

Ставим тематичность 10, похожесть 4 и смотрим, что у нас получится.

Получилось 37 конкурентов. Но все равно еще их проверим вручную, выгрузим в Excel и если надо уберем не нужные.

Теперь переходим на вкладку групповой отчет и вводим всех наших конкурентов, которых мы нашли выше. Жмем – анализировать.

Получаем список ключевых слов этих всех сайтов. Но мы еще полностью не раскрыли тематику. Поэтому мы переходим в конкуренты группы.

И теперь мы получаем всех конкурентов, тех всех сайтов которые мы ввели. Их в несколько раз больше и здесь так же много общетематических. Фильтруем их по похожести, допустим 30.

Получаем 841 конкурента.

Здесь мы можем посмотреть, сколько страниц у этого сайта, трафика и сделать выводы, какой же конкурент самый эффективный.

Экспортируем всех их в Excel. Перебираем руками и оставляем только конкурентов нашей ниши, можно отметить самых эффективных товарищей, чтобы потом оценить их и глянуть какие у них есть фишки на сайт, запросы дающие много трафика.

Теперь мы опять заходим в групповой отчет и добавляем уже всех найденных конкурентов и получаем список ключевых слов.

Здесь мы можем список сразу фильтрануть по “!wordstat” Больше 10.

Вот они наши запросы, теперь мы можем их добавить в KeyCollector и указать, чтобы не добавлялись фразы, которые есть уже в любой другой группе KeyCollector.

Теперь мы чистим наши ключи, и расширяем, группируем наше семантическое ядро.

Услуги по сбору семантического ядра

В данной отрасли можно найти не мало организаций, которые готовы предложить вам услуги по кластеризации. Например, если вы не готовы тратить время на то, чтобы самостоятельно изучить тонкости кластеризации и выполнить ее собственными руками, то можно найти множество специалистов, готовых выполнить эту работу.

Yadrex

Одна из первых на рынке, кто начал использовать искусственный интеллект для создания сематического ядра. Руководитель компании сам профессиональный вебмастер и специалист по SEO технологиям, поэтому он гарантирует качество работы своих сотрудников.

Кроме того, вы можете позвонить по указанным телефонам, чтобы получить ответы на все интересующие вас вопросы относительно работы.

Заказывая услуги, вы получите файл, где будут указаны группы содержания ядра и его структура. Дополнительно вы получаете структуру в mindmup.

Стоимость работы варьируется в зависимости от объема, чем больше объем работы, тем дешевле стоимость одного ключа. Максимальная стоимость для информационного проекта будет 2,9 рублей за один ключ. Для продающего 4,9 рублей за ключ. При большом заказе предоставляются скидки и бонусы.

Заключение

На этом создание семантического ядра для информационного сайта завершено.

Советую вам мониторить историю изменений программы KeyCollector, потому что она постоянно дополняется новыми инструментами, например недавно был добавлен youtube для парсинга. С помощью новых инструментов, вы можете ещё больше расширить свое семантическое ядро.

Что такое семантическое ядро сайта? Семантическое ядро сайта (далее по тексту СЯ ) — это совокупность ключевых слов и фраз, по которым ресурс продвигается в поисковых системах и которые свидетельствуют о принадлежности сайта к определённой тематике .

Для успешного продвижения в поисковых системах, ключевые слова должны быть правильно сгруппированы и распределены по страницам сайта и в определённом виде содержаться в мета-описаниях (title , description , keywords), а также в заголовках H1-H6. При этом, нельзя допускать переспама, чтобы не «улететь» в Баден-Баден.

В этой статье мы постараемся взглянуть на вопрос не только с технической точки зрения, но и посмотреть на проблему глазами владельцев бизнеса и маркетологов.

Каким бывает сбор СЯ?

- Ручным — возможно для небольших сайтов (до 1000 ключевых слов).

- Автоматическим — программы не всегда верно определяют контекста запроса, поэтому могут возникнуть проблемы с распределением ключевиков по страницам.

- Полуавтоматическим — фразы и частотность собираются автоматически, распределение фраз и доработка происходит вручную.

В нашей статье мы рассмотрим полуавтоматический подход созданию семантического ядра, так как он является наиболее эффективным.

Кроме того, есть два типовых случая при составлении СЯ:

- для сайта с готовой структурой;

- для нового сайта .

Более предпочтительным является второй вариант, так как есть возможность составить идеальную структуру сайта под поисковые систему.

Из чего состоит процесс составления СЯ?

Работы по формированию семантического ядра делятся на следующие этапы:

- Выделение направлений, по которым будет продвигаться сайт.

- Сбор ключевых слов, анализ похожих запросов и поисковых подсказок.

- Парсинг частотности, отсев «пустых» запросов.

- Кластеризация (группировка) запросов.

- Распределение запросов по страницам сайта (составление идеальной структуры сайта).

- Рекомендации по использованию.

Чем качественней Вы составите ядро сайта, а качество в этом случае означает широту и глубину проработки семантики, тем более мощный и надёжный поток поискового трафика сможете направить на сайт и тем больше привлечёте клиентов.

Как составить семантическое ядро сайта

Итак, более подробно рассмотрим каждый пункт с различными примерами.

На первом шаге важно определить, какие товары и услуги, присутствующие на сайте будут продвигаться в поисковой выдаче Яндекса и Google.

Пример №1. Допустим на сайте есть два направления услуг: ремонт компьютеров на дому и обучение работе с Word/Exel на дому. В данном случае было принято решение, что обучение уже не пользуется спросом, поэтому его нет смысла продвигать, а значит и собирать по нему семантику. Еще один важный момент, нужно собирать не только запросы, содержащие «ремонт компьютеров на дому» , но и «ремонт ноутбуков, ремонт ПК» и прочие.

Пример №2. Компания занимается малоэтажным строительством. Но при этом строит только деревянные дома. Соответственно, запросы и семантику по направлениям «строительство домов из газобетона» или «строительство домов из кирпича» можно не собирать.

Сбор семантики

Мы рассмотрим два основных источника ключевых слов: Яндекс и Google. Расскажем, как собрать семантику бесплатно и коротко обозрим платные сервисы, позволяющие ускорить и автоматизировать данный процесс.

В Яндексе сбор ключевых фраз осуществляется из сервиса Яндекс.Вордстат и в Гугле через статистику запросов в Google AdWords. При наличии, в качестве дополнительных источников семантики, можно использовать данные Яндекс Вебмастер и Яндекс Метрики, Гугл Вебмастер и Google Analytics.

Сбор ключевых слов из Яндекс.Вордстат

Сбор запросов из Вордстата можно считать бесплатным. Для просмотра данных этого сервиса вам понадобиться только аккаунт в Яндексе. Итак, заходим на wordstat.yandex.ru и вводим ключевое слово. Рассмотрим пример сбора семантики для сайта компании по прокату авто.

Что мы видим на этом скриншоте?

- Левая колонка . Здесь обозначен основной запрос и его различные вариации с «хвостом». Напротив каждого запроса стоит число, показывающее, сколько данный запрос в общем был использован различными пользователями.

- Правая колонка . Запросы похожие на основной и показатели их общей частотности. Здесь мы видим, что человек, который хочет взять автомобиль в аренду, кроме запроса «прокат авто», может использовать «аренда авто», «прокат машин», «авто напрокат» и прочие. Это очень важные данные, на которые нужно обращать внимания, чтобы не упустить ни одного запроса.

- Региональность и история . Выбрав один из возможных вариантов, можно проверить распределение запросов по регионам, количество запросов в отдельном регионе или городе, а также тенденцию к изменениям с течением времени или со сменой времени года.

- Устройства , с которых совершался запрос. Переключая вкладки, можно узнать, с каких устройств чаще всего осуществляется поиск.

Проверяйте разные варианты ключевых фраз и полученные данные фиксируйте в таблицы Exel или в таблицах Google. Для удобства установите плагин Yandex Wordstat Helper. После его установки рядом с поисковыми фразами появятся плюсики, при нажатии на который слова будет копироваться, не нужно будет выделять и вставлять показатель частотности вручную.

Сбор ключевых слов из Google AdWords

К сожалению у Google нет открытого источника поисковых запросов с их показателями частотности, поэтому здесь нужно действовать обходными путями. И для этого нам понадобиться рабочий аккаунт в Google AdWords.

Регистрируем аккаунт в Google AdWords и пополняем баланс на минимально возможную сумму — 300 рублей (на неактивном в плане бюджета аккаунте, отображаются приблизительные данные). После этого, заходим в «Инструменты» — «Планировщик ключевых слов».

Откроется новая страница, где во вкладке «Поиск новых ключевых слов по фразе, сайту или категории» введите ключевик.

Скролим вниз, нажимаем «Получить варианты» и видим примерно такую картину.

- Основной запрос и среднее число запросов в месяц. Если аккаунт будет не проплачен, то вы увидите приблизительные данные, то есть среднее количество запросов. Когда на аккаунте есть средства, будут показаны точные данные, а также динамика изменения частотности введённого ключевика.

- Ключевые слова по релевантности. Это то же самое, что похожие запросы в Яндекс Вордстат.

- Скачивание данных. Удобен этот инструмент тем, что данные полученные в нём можно скачать.

Мы рассмотрели работу с двумя основными источниками статистики по поисковым запросам. Теперь перейдём к автоматизации этого процесса, потому что сбор семантики вручную занимает слишком много времени.

Программы и сервисы для сбора ключевых слов

Key Collector

Программа устанавливается на компьютер. В программе подключаются рабочие аккаунты от куда будет собираться статистика. Далее создаётся новый проект и папка для ключевых слов.

Выбираем «Пакетный сбор слов из левой колонки Yandex.Wordstat», вводим запросы, по которым собираем данные.

На скриншоте введён пример, на самом деле для более полного СЯ, здесь дополнительно нужно собрать все варианты запросов с марками автомобилей и классами. Например, «bmw на прокат», «купить toyota с правом выкупа», «аренда внедорожника» и так далее.

СловоЕб

Бесплатный аналог предыдущей программы. Это можно считать, как плюсом — не нужно платить, так и минусом — у программу значительно урезан функционал.

Для сбора ключевых слов, действия те же.

Rush-analytics.ru

Онлайн сервис. Его основное преимущество — не нужно ничего скачивать и устанавливать. Зарегистрировался и пользуйся. Сервис платный, но при регистрации на вашем счету есть 200 монет, чего вполне хватит, чтобы собрать небольшую семантику (до 5000 запросов) и спарсить частотность.

Минус — сбор семантики только из Wordstat.

Проверка частотности ключевых слов и запросов

И опять замечаем уменьшение количества запросов. Идём дальше и попробуем другую словоформу того же запроса.

Отмечаем, что в единственном числе, данный запрос ищет гораздо меньшее количество пользователей, значит первоначальный запрос, для нас является более приоритетным.

Такие манипуляции необходимо провести с каждым словом и словосочетанием. Те запросы, по которым итоговая частотность оказывается равной нулю (при использование кавычек и восклицательного знака), отсеиваются, т.к. «0» — говорит о том, что такие запросы никто не вводит и эти запросы являются лишь частью других. Смысл составления семантического ядра состоит в том, чтобы отобрать запросы, которые используют люди для поиска. Все запросы затем помещаются в таблицу Exel, группируются по смыслам и распределяются по страницам сайта.

В ручную это сделать просто не реально, поэтому в интернете существует множество сервисов, платных и бесплатных, которые позволяют сделать это автоматически. Приведём несколько:

- megaindex.com;

- rush-analytics.ru;

- tools.pixelplus.ru ;

- key-collector.ru.

Удаляем нецелевые запросы

После просева ключевиков следует удалить не нужные. Какие поисковые запросы можно удалять из списка?

- запросы с названиями фирм конкурентов (можно оставить в контекстной рекламе );

- запросы товаров или услуг, которые Вы не продаёте;

- запросы, где указывается район или область, в которой Вы не работаете.

Кластеризация (группировка) запросов под страницы сайта

Суть данного этапа — объединить похожие по смыслу запросы в кластеры, а затем определить на какие страницы они будут продвигаться. Как же понять какие запросы продвигать на одну страницу, а какие на другую?

1. По типу запроса.

Нам уже известно, что все запросы в поисковых системах делятся на несколько видов, в зависимости от цели поиска:

- коммерческие (купить, продажа, заказать) — продвигаются на посадочные страницы, страницы товарных категорий, карточки товаров, страницы с услугами, прайсы;

- информационные (где, как, зачем, почему) — статьи, темы форумов, рубрика ответ на вопрос;

- навигационные (телефон, адрес, название бренда) — страница с контактами.

Если сомневаетесь, к какому типу относится запрос, введите его строку поиска и проанализируйте выдачу. По коммерческому запросу будет больше страниц с предложением услуг, по информационному — статей.

Также есть геозависимые и геонезависимые запросы . Большинство коммерческих запросов является геозависимыми, так как люди в большей степени доверяют компаниям, находящихся в их городе.

2. Логика запроса.

- «купить iphone x» и «iphone x цена» — нужно продвигать на одну страницу, так как и в первом и во втором случае, осуществляется поиск одного и того же товара, и более подробной информации о нём;

- «купить iphone» и «купить iphone x» — нужно продвигать на разные страницы, так как в первом запросе мы имеем дело с общим запросом (подойдёт для товарной категории, где расположились айфоны), а во втором пользователь ищет конкретный товар и этот запрос следует продвигать на карточку товара;

- «как выбрать хороший смартфон» — данный запрос логичнее продвигать на статью блога с соответствующим названием.

Посмотреть поисковую выдачу по ним. Если, проверить, на какие страницы у различных сайтов ведут запросы «строительство домов из бруса» и «строительство домов из кирпича», то в 99% случаев это разные страницы.

4. Автоматическая группировка с помощью ПО и ручная доработка.

1-ый и 2-ой способы отлично подходят для составления семантического ядра небольших сайтов, где собрано максимум 2-3 тысячи ключевых слов. Для большого СЯ (от 10000 до бесконечности запросов), нужна помощь машин. Вот несколько программ и сервисов, которые позволяют выполнять кластеризацию:

- KeyAssistant — assistant.contentmonster.ru;

- semparser.ru;

- just-magic.org;

- rush-analytics.ru;

- tools.pixelplus.ru ;

- key-collector.ru.

После завершения автоматической кластеризации, необходимо проверить результат работ программы в ручную и если допущены ошибки — исправлять.

Пример: программа может отправить в один кластер следующие запросы: «отдых в сочи 2018 отель» и «отдых в сочи 2018 отель бриз» — в первом случае пользователь ищет различные варианты отелей для проживания, а во втором, конкретный отель.

Чтобы исключить возникновение подобных неточностей, требуется вручную всё проверять и при обнаружении ошибок, править.

Что делать дальше, после составления семантического ядра?

На основе собранного семантического ядра, далее мы:

- составляем идеальную структуру (иерархию) сайта, с точки зрения поисковых систем;

или по согласованию с заказчиком меняем структуру старого сайта; - пишем технические задания для копирайтеров по написанию тексту с учётом того кластера запросов, которые будут на эту страниц продвигаться;

или дорабатываем старые статьи тексты на сайте.

Выглядит это примерно так.

Под каждый сформированный кластер запроса мы создаём страницу на сайте и определяем ему место в структуре сайта. Наиболее популярные запросы, продвигаются на самые верхние страницы в иерархии ресурса, менее популярные располагаются под ними.

И для каждой из этих страниц, у нас уже собраны запросы, которые мы будем на них продвигать. Далее пишем ТЗ копирайтерам, чтобы сделать текст для этих страниц.

Техническое задания для копирайтера

Как и в случае со структурой сайта, опишем этот этап в общих чертах. Итак, техническое задание на текст:

- количество символов без пробела;

- заголовок страницы;

- подзаголовки (если будут);

- список слов (на основе нашего ядра), которые должны быть в тексте;

- требование по уникальности (всегда требуйте 100% уникальности);

- желаемый стиль текста;

- прочие требования и пожелания по тексту.

Помните не надо пытаться продвигать на одну страницу +100500 запросов, ограничьтесь 5-10 +хвост, иначе получите бан за переоптимизацию и надолго вылетите из игры за места в ТОПе.

Вывод

Составление семантического ядра сайта — кропотливый и тяжёлый труд, которому нужно уделить особо пристальное внимание, потому что именно на нём базируется дальнейшее продвижение сайта. Следуйте простой инструкции, приведённой в этой статье и действуйте.

- Выберите направление продвижения.

- Соберите все возможные запросы из Яндекс и Google (используйте специальные программы и сервисы).

- Проверьте частотность запросов и избавьтесь от пустышек (у которых частотность — 0).

- Удалите нецелевые запросы — услуги и товары, которые вы не продаёте, запрос с упоминание конкурентов.

- Сформируйте кластеры запросов и распределите их по страницам.

- Создайте идеальную структура сайта и составляйте ТЗ по наполнению сайта.