Инструкция

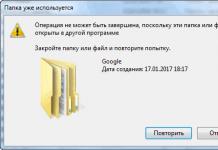

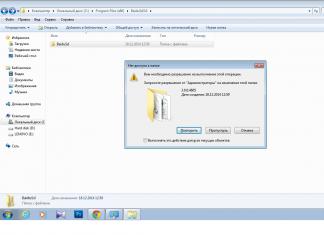

Проверьте полный объем памяти, выделенный видеокарте. Для этого запустите встроенную в windows утилиту dxdiag, перейдите на вкладку "Экран" и найдите на ней значение "всего памяти". Это значение и есть полный объем памяти, который может использовать видеокарта - сумма объемов встроенной памяти и выделяемой из оперативной памяти компьютера. Если вас не устраивает это значение - можно попытаться его изменить.

Запустите "Панель управления" вашей видеокарты. На панели слева найдите пункт меню "Буфер кадров UMA". Название может различаться в зависимости от модели видеокарты. Установите ползунок в максимальное значение. Если в "Панели управления" видеокарты нет подобного меню, можно попытаться изменить объем выделяемой видеопамяти через BIOS.

Войдите в BIOS компьютера или . Для этого сразу после включения компьютера нажмите и удерживайте клавишу "Del" на клавиатуре. Если загрузка продолжается как обычно, попробуйте клавиши клавиши "F2" и "Esc". В случае, если в BIOS зайти не удалось, обратитесь к документации, поставляемой вместе с устройством, т.к. клавиши, зарезервированные для входа в BIOS, могут различаться в зависимости от модели компьютера.

Теперь необходимо найти параметр, отвечающий за объем оперативной памяти, выделяемый для работы видеокарты. В зависимости от модели компьютера, он может называться: "BIOS VGA sharing memory", "VGA memory", "Video memory", "AGP Aperture Size". Так же возможны другие названия. Отсутствие таких или похожих пунктов меню в BIOS может означать, что ваша материнская плата не поддерживает установку максимального объема выделяемой видеопамяти. В этом случае выделяется автоматически, по мере необходимости.

Обратите внимание

Если расходовать системную память на нужды видеосистемы, то для нужд процессора ее останется меньше.

Помните о том, что системная память не может быть полноценной заменой собственной видеопамяти.

Источники:

- как увеличить размер оперативки для приложений

Объем встроенной оперативной памяти видеокарты отражает, какой объем информации может храниться на самой графической плате. Чем больше памяти имеется на видеокарте, тем больше данных может в ней храниться без использования медленного доступа к ОЗУ. Хотя большой размер видеопамяти не оказывает влияния на скорость обработки графики, при пользовании увеличенной шиной данных или системной оперативной памятью для кэширования часто отображаемых элементов, скорость видеоадаптера способна существенно увеличиваться.

Вам понадобится

- Ноутбук, видеокарта, отвертка

Инструкция

Второй доступный способ самостоятельного увеличения видеопамяти - это замена видеокарты, возможный только в случае, если имеет , то есть конструктивно выполненную на отдельной плате, содержащей графический процессор (или видеочип) и микросхемы видеопамяти. Сама видеокарта вставлена в разъем материнской платы и зафиксирована парой винтов, но, чтобы туда добраться, потребуется разобрать ноутбук.

Поднимите верхний край клавиатуры и отключите шлейф посредством освобождения фиксирующей скобы. Справа находится система охлаждения видеокарты.

Освободите остальные разъемы и открутите винты, держащие верхний каркас корпуса. Переверните оставшуюся часть ноутбука и выкрутите винты обратной стороны по всему периметру, не забыв про винт, расположенный под батареей. Вы увидите слева систему охлаждения процессора и , а справа расположена видеокарта, которая легко посредством ослабления четырёх блестящих винтов.

Извлеките видеокарту и после этого можете устанавливать новую. Вставьте видеокарту ровно, без уклонов, в слот AGP (или PCI-E, если карта поддерживает подключение PCI Express). Примените немного усилий при медленной установке нового устройства. Это необходимо для того, чтобы две стороны карты плотно зашли в слот. Закрепите новую видеокарту с помощью винтиков.

Увеличение видеопамяти – дело непростое. Существует несколько способов добиться желаемого результата, но все эти методы не очень надежны, а иногда и вовсе бесполезны или даже могут повредить вашему оборудованию. Но если вы хотите поэкспериментировать со своим железом, то карты вам в руки, а точнее – видеокарты.

Инструкция

Настройка в BIOS. К сожалению, не все видеокарты поддерживают такую возможность. И не BIOS имеют возможность управлять и частотой видеокарты. Более подробно рассказать про данный метод невозможно, так как во всех BIOS`ах расположение данной опции различно, вам остается только самим найти данную функцию. Единственное, что можно подсказать, так это то, что нужно искать строку с названием порта вашей видеокарты (PCI-e, AGP), слово memory или др., везде по-разному. Но прежде, чем искать эту функцию, вам нужно почитать на форумах, есть ли она в вашей версии БИОСа и поддерживает ли «разгон» через БИОС.

Несмотря на большой объем памяти интегрированных видеоадаптеров, они не справляются с большинством тяжелых приложений. Для того чтобы иметь возможность играть в игры, требующие наличия мощной видеокарты, установите дискретный видеоадаптер.

Приобретите подходящую видеокарту. Разберите ноутбук, открутив нужное количество крепежных шурупов. Очень внимательно изучите подключенные шлейфы до полного снятия нижней крышки.

Подключите полноценную видеокарту к предназначенному для нее разъему. Подключите все ранее отсоединенные шлейфы и соберите ноутбук. Включите это устройство.

Установите полноценные драйверы для новой видеокарты. Учтите, что использование дискретного видеоадаптера требует большей мощности. Это означает, что ваш ноутбук будет работать значительно меньше без подзарядки. Чтобы иметь возможность переключать видеоадаптеры, установите специальную программу.

Если с увеличением памяти видеокарты вы не заметили увеличения производительности, то лучше вернуть прежний показатель памяти платы. Сделать это можно точно таким же путем.

Полезный совет

Увеличивать память встроенной видеокарты имеет смысл, если у вас компьютер с мощным процессором и достаточным количеством оперативной памяти (минимум два гигабайта). Еще учтите тот факт, что даже с увеличением памяти некоторые современные игры могут попросту не запуститься. Но чтобы те из них, которые запустятся, работали без «подвисаний» и постоянных «вылетов», настройки графики и разрешение дисплея компьютера в играх должны быть минимальные.

У видеоадаптеров имеется свой запас , которую он использует в обработки информации. Чем больше ее размер, тем быстрее происходит видеообработка. Однако интегрированные видеокарты ноутбуков не имеют собственной памяти, они работают за счет компьютерной.

Вам понадобится

- - новый видеоадаптер или новая оперативная память;

- - отвертка.

Инструкция

Купите дополнительную планку оперативной памяти, если ваша видеокарта интегрирована в системную плату компьютера. При этом узнайте точно модель и, еще лучше, маркировку материнской платы. Лучше всего посмотреть конфигурацию оборудования в интернете, введя в поисковике название модели.

Также узнайте, имеется ли разъем для установки дополнительного модуля памяти. Все это нужно для того, чтобы выяснить, какая оперативная память совместима с вашим устройством и поддерживает ли оно установку дополнительного оборудования.

Завершите работу компьютера, отключите его от источника питания. Переверните . Открутите все имеющиеся крепежные элементы верхней крышки, аккуратно снимите ее. Иногда задняя крышка компьютера имеет несколько крышек, если вы точно не знаете, под какой , лучше всего снять их полностью все.

Найдите отсек, в котором находится оперативная память. Аккуратно вставьте туда новую плату, закрепите ее. Верните на место крышку ноутбука, прикрутив ее шурупами к корпусу. Включите ноутбук. Обратите внимание на скорость загрузки.

Если у вас не ноутбук, а компьютер со встроенным видеоадаптером, действуйте аналогично. Однако материнские платы обычных компьютеров в большинстве своем поддерживают установку внешнего адаптера, узнайте точно возможность его подсоединения и выясните, какие именно параметры видеокарты будут совместимы с вашей материнской платой. Также это применимо к ноутбукам, однако действительно очень мало моделей, поддерживающих возможность подключения внешнего дополнительного видеоадаптера.

Обратите внимание

Ознакомьтесь с условиями гарантии перед разборкой ноутбука.

Полезный совет

Покупайте ноутбуки с внешними видеокартами или с возможностью дальнейшего подключения таковых.

Параметры работы многих видеоадаптеров можно изменить самостоятельно. Обычно этот метод используют для увеличения производительности устройства при работе с определенными приложениями.

Вам понадобится

- - Riva Tuner;

- - 3D Mark.

Инструкция

Для успешного разгона видеокарты вам потребуется программа Riva Tuner. Она была изначально разработана для работы с устройствами компании nVidia, но в настоящее время активно используется для настройки видеоадаптеров других производителей. Скачайте эту программу и установите ее. Если вы хотите отслеживать изменения производительности устройства, то установите приложение 3D Mark.

Запустите Riva Tuner и откройте вкладку «Главная». Перейдите в меню «Системные настройки», которое расположено в графе «Настройки драйвера». Для этого кликните по графическому изображению видеокарты. Установите галочку напротив параметра «Включить разгон на уровне драйвера». Это обязательное условие для успешного выполнения процедуры оптимизации видеоадаптера. Выберите в появившемся окне пункт 3D.

Найдите поле «Частота памяти». Именно этот параметр вам необходимо изменить. Оставьте программу Riva Tuner и запустите 3D Mark. Выполните анализ . Запомните полученные цифры. Увеличьте частоту памяти видеокарты на 50-100 МГц, передвинув ползунок в нужном направлении. Нажмите кнопку «Тест» и убедитесь в том, что видеокарта работает в данном режиме без сбоев.

Выполняйте это цикл до тех пор, пока в работе устройства не появятся ошибки. Теперь нажмите кнопку «Применить», предварительно поставив галочку рядом с пунктом «Загружать настройки с Windows». Это обязательное действие. В противном случае вам придется повторять процесс разгона после каждой перезагрузки ПК.

Видео по теме

Полезный совет

Позаботьтесь об установке качественной системы охлаждения для видеоадаптера. Увеличение ее производительности неизбежно приведет к повышению температуры устройства.

Графическая память – это буфер обмена видеокарты, который является одной из основных ее характеристик. Увеличить ее можно разными способами в зависимости от ваших возможностей и конфигурации компьютера.

Вам понадобится

- - компьютер;

- - доступ в интернет.

Инструкция

Перед тем, способ увеличения графической памяти вашего компьютера, просмотрите текущую его конфигурацию в свойствах рабочего стола на вкладке «Адаптер». Если у вас используется внешняя видеокарта, подключенная к материнской плате, вы можете заменить ее на более современную модель, подходящую к модели системной платы. Параметры совместимости уточните на официальном сайте производителя видеоадаптеров на странице просмотра конфигурации устройства.

В случае, если вы являетесь владельцем , и в его конфигурации имеется встроенный в материнскую плату видеоадаптер, проверьте по ее модели возможность установки . Если материнская плата не поддерживает установку нового видеоадаптера, вы можете заменить ее, а можете использовать распределение части оперативной памяти компьютера на графическую память в БИОСе. При этом общее быстродействие компьютера станет немного ниже, а буфер обмена видеокарты станет работать быстрее.

Если есть возможность установки дополнительных модулей оперативной памяти, купите дополнительную планку, подходящую модели системной платы. Если слоты для памяти уже заполнены, замените память на платы с более высокими показателями касательно ее объема для дальнейшего распределения ее на видеокарту компьютера. Если же интегрированная видеокарта используется в обычном компьютере, в большинстве случаев имеется возможность установки внешнего модуля.

Используйте различные программные методы для увеличения видеопамяти. Вы можете также освободить графическую память при помощи завершения неиспользуемых программ, установки режима максимальной производительности в свойствах компьютера и так далее.

Также вы можете скачать для вашего компьютера специальное программное обеспечение, которое создает дополнительные профили к запускаемым играм, при которых после перезагрузки компьютера освобождается значительное количество видеопамяти за счет закрытия некоторых системных программ, не требуемых для запуска компьютерных игр.

Обратите внимание, что лучшими способами увеличения графической памяти все же будет замена оборудования, снижение ресурсопотребляемости компьютера за счет закрытия программ, работающих в фоновом режиме и упрощение пользовательского интерфейса. При неисправной работе программного обеспечения и игр также убедитесь в том, что проблема заключается именно в видеокарте, а не в другом оборудовании.

» я вкратце упомянул о функциональном назначении всех компонентов этого девайса. Сегодня разберемся что такое графическая память видеокарты и зачем она нужна?

Что такое видеопамять

Вероятно, вы знаете, что за рендеринг любого изображения в компьютере отвечает графический чип – например, он просчитывает взаимодействие объектов в игре.

Промежуточные данные, которые затем выводятся на монитор, хранятся как раз в видеопамяти. Связаны эти блоки между собой, шиной данных (подробнее о том, что это такое, ее разрядности и влиянии на работу устройства, вы можете почитать ).

В современных графических ускорителях сейчас используется память GDDR5 (за исключением бюджетных моделей, некоторые из которых все еще работают на DDR3). По сути, это обычная оперативная память, которая есть в любом ПК.

Но в отличие от оперативки, плата видеопамяти впаяна наглухо, поэтому заменить ее, не раскурочив видеокарту, нет совершенно никакой возможности).

Зачем реализовано такое решение? Не в целях «защиты от дурака», как, вероятно, вы могли подумать. Сделано это для того, чтобы пользователь, которому уже не хватает видеопамяти для запуска какой‐нибудь новинки игропрома, не докупил по дешевке дополнительный модуль памяти, а покупал новую навороченную видеокарту.

Хотя, если вы не верите в теорию заговора, можете проигнорировать мое мнение.

Больше – лучше, или нет?

Предметом сравнительной фаллометрии рядовых юзеров часто выступает объем видеопамяти. Случилось это с подачи маркетологов – втюхивая новый продукт, они прожужжат вам все уши по этому поводу. Более продвинутые юзеры, особенно геймеры, которым приходится, жертвуя личным временем, предаваться любимому хобби, обращают внимание, в первую очередь, на частоту памяти (ну и, естественно на частоту ядра).

Более продвинутые юзеры, особенно геймеры, которым приходится, жертвуя личным временем, предаваться любимому хобби, обращают внимание, в первую очередь, на частоту памяти (ну и, естественно на частоту ядра).

Почему так? Не так важно, сколько данных может запомнить видеокарта – если она работает медленно, даже разгон не всегда поможет существенно увеличить производительность в играх.

Сколько нужно видеопамяти

Не буду углубляться, как сильно изменились видеоигры за последние 5 лет – если вы «в теме», то и сами все прекрасно видите. Такое качество графики требует мощной видеокарты – если вы, конечно, хотите играть на приемлемых настройках, при этом не страдая от «слайдшоу» во время просадки FPS.

Однако качество графики – не единственная проблема, с которой сталкиваются современные геймеры. В игропроме хорошим тоном стало делать игры с открытым бесшовным миром (если жанр подразумевает такую «фичу» – например, РПГ или шутер).

Игра, в которой пользователю придется постоянно ждать загрузки локаций, имеет высокий шанс стать провальной.

Чтобы запомнить все (или хотя бы ближайшие) объекты такого игрового мира, требуется солидный объем видеопамяти. Для современных игр нормой стал показатель от 3 Гб.

Не хочу вас расстраивать, но это только сегодня пока так – уже через пару лет топовые видеокарты может и не будут тянуть новинки на ультра‐настройках. А вы как думали?

Увы, большинство разработчиков нацелены на массового потребителя, поэтому акцент они делают на YOBA‐играх, где в угоду «графонию» можно пожертвовать остальными составляющими – сюжетом, продуманным ЛОРом, необычными квестами, которые отличаются от привычных «убить всех».

Какие выводы мы можем сделать

Чуть не забыл, не нужно размышлять, как использовать всю видеопамять – в играх она задействуется автоматически, даже если система отображает, что доступно меньше. Исходя из вышесказанного, при выборе видеокарты я советую, в первую очередь, ориентироваться на частоту памяти, игнорируя объем, если бюджет на апгрейд ограничен.

Исходя из вышесказанного, при выборе видеокарты я советую, в первую очередь, ориентироваться на частоту памяти, игнорируя объем, если бюджет на апгрейд ограничен.

А на этом у меня все. До следующих встреч на страницах моего блога. Не забываем на новостную рассылку и делиться публикациями в социальных сетях!

Все больше современных программ и игр предъявляют повышенные требования к компьютерному «железу», в частности, к графическим адаптерам. Нехватка памяти видеокарты приводит к тому, что многие приложения не только зависают, но и не запускаются вообще. И тут остро встает вопрос о том, как увеличить объем видеопамяти, и возможно ли это сделать. Далее будет рассмотрено несколько вариантов, которые позволяют, если не увеличить ее, то по крайней мере, использовать наиболее оптимально.

Какова роль видеопамяти в системе

Наверное, нет нужды говорить о том, что память графического адаптера в чем-то очень сильно напоминает основную оперативную память компьютерной системы.

На нее возложены практически те же функции загрузки основных программных компонентов программ и приложений с передачей вычислений графическому процессору. Понятно, что при малом объеме, как ни пытайся, загрузить туда больше того, на что она рассчитана, не получится. Поэтому многие игры не то, что функционируют со сбоями, так иногда еще и не работают вообще. Но проблема того, как увеличить видеопамять видеокарты, как оказывается, решается достаточно просто. Правда, назвать это именно увеличением нельзя, поскольку физически размер видеопамяти не изменяется.

Определяем тип графического адаптера

Прежде чем заниматься поиском решения проблемы и ответа на вопрос о том, как увеличить видеопамять, нужно определиться с типом установленного в системе графического адаптера.

Они бывают двух типов: интегрированные (встроенные в материнскую плату) и дискретные (вставляемые в специальные слоты).

Визуально интегрированный адаптер можно определить по наличию рядом находящихся разъемов HDMI, USB, LAN и т.д.

Получить более подробную информацию можно в «Диспетчере устройств», вызвав его либо из «Панели управления», либо из консоли «Выполнить» (Win +R) командой devmgmt.msc.

Однако наиболее полные данные содержатся в диалоговом окне DirectX, вызываемом из меню «Выполнить» строкой dxdiag. На вкладке «Экран» и будет представлена вся информация. Кстати сказать, узнать основные характеристики интегрированных видеоадаптеров можно только таким способом.

Как увеличить видеопамять дискретных карт за счет повышения производительности

Для начала рассмотрим вопрос того, как увеличить видеопамять дискретной видеокарты. В идеале, конечно, проще всего купить новую, однако современные адаптеры стоят весьма недешево, поэтому лучше заняться настройкой имеющегося в наличии.

Исходя из того, что сегодня на рынке предлагаются в основном чипы NVIDIA и AMD/ATI, стоит использовать сопутствующее программное обеспечение, которое поставляется в предустановленном виде при покупке ПК или ноутбука.

Также для Windows-систем в плане улучшения производительности прекрасно подойдут утилиты вроде ATITool или MSI Afterburner, которые позволяют постепенно увеличивать тактовую частоту графического процессора, оставляя показатель памяти без изменений.

Кроме того, можно использовать и программы вроде Catalyst, PhysX или Riva Tuner, способные оптимизировать память видеочипа для использования в определенных играх или других приложениях, высвобождая ресурсы.

Настройки буфера кадра

Теперь посмотрим, как увеличить видеопамять на ноутбуке. В большинстве своем современные бюджетные модели оборудованы интегрированными чипами.

Просмотреть параметры выделенной памяти можно через «Диспетчер устройств», где из меню правого клика нужно выбрать свойства и перейти к вкладке "Драйвера". Здесь имеется строка параметров кадрового буфера UMA, где и находится требуемое значение. Но такого пункта может и не быть, поэтому вопрос о том, как увеличить видеопамять, должен решаться другим методом. Каким? Настройками BIOS, которые предполагают изменение распределяемой динамической памяти.

Как увеличить видеопамять за счет оперативной (распределяемой) через BIOS

В первичной системе ввода/вывода, которая вызывается нажатием определенных клавиш, из сочетаний или специальных кнопок, нужно найти раздел наподобие Video RAM или Shared Memory.

Как увеличить видеопамять с применением таких настроек? Для улучшения производительности изменяется параметр апертуры, обозначенный как AGP OverVoltage. При этом нужно помнить, что прирост рассчитывается по определенной формуле. Для примера возьмем 16 Мб памяти интегрированного адаптера и 256 Мб основной оперативной памяти. Результат составит 256 Мб/(16 Мб/2)=32 Мб. А вот и интересный парадокс. Для ОЗУ 256 Мб и памяти адаптера 64 Мб увеличение будет 256 Мб/(64 Мб/2)=8 Мб.

В настройках VGA Shared Memory (он же буфер UMA) нужно установить требуемый параметр, однако выставлять максимальное значение не рекомендуется. Оптимальным вариантом считается установка значения, которое только вдвое превышает установленное по умолчанию.

Стоит ли этим заниматься

Напоследок нужно добавить, что вопрос о том, как увеличить видеопамять программными средствами, не изменяя ее физическим способом, является весьма условным, ведь в конечном итоге речь идет только о максимально эффективном ее использовании. По сути, в чем-то это напоминает разгон графического адаптера. Но, если уж вы этим занялись, нужно быть очень осторожным, а то такие действия могут привести только к тому, что карта выйдет из строя. По крайней мере, не следует устанавливать максимально возможные пиковые значения любого параметра, хотя графические адаптеры, равно как и любые другие устройства, так сказать, имеют определенный запас прочности.

РЕФЕРАТ

по дисциплинеЭВМ и периферийные устройства

на тему:

«Видеокарта. Устройство, функции»

(ФИО полностью)

Москва 2015

Что такое видеокарта? ….………………………………………………………...4

Для чего используется видеопамять? ……………………………………………..6

История видеокарт ………………………………………………………………… 7

IBM Monochrome Display Adapter …………………...…………………………… 8

Первый IBM PC…………………………………………………………………..… 8

Видеокарта IBM CGA……………………………………………………………… 9

Видеокарта EGA …………………………………………………………………. 10

Видеокарта IBM VGA ………………………………………………………… 12

Видеокарта S3 Virge ……………………………………………………………... 14

Видеокарта Voodoo Graphics…………………………………….……...……….. 16

Видеокарта Diamond Monster ………………………………………………..….. 16

Видеокарта Voodoo2 с первым в мире SLI……………………………….…….. 18

Видеокарта RIVA TNT от NVIDIA ………………………………...………….. 19

Видеокарта 3D Rage Pro ………………..………………………....………..……. 20

Видеокарта Voodoo 3 от 3Dfx………………………………………….………… 21

Видеокарта Matrox Millenium G40…………………………………..…..………. 22

Видеокарта Rage 128 …………………………………………………………….23

Видеокарта ATI Rage Fury MAXX ……………………………………………….24

Видеокарта Voodoo5……………………………………………………………….25

Видеокарта GeForce 256………………………………………………………… 25

Видеокарта BitBoys Axe………………………………………………………… 28

Видеокарта Glaze3D……………………………………………………………… 28

Видеокарта NVIDIA GeForce2…………………………………………………….29

Видеокарта GeForce3 с чипом NV20…………………………………………… 29

Видеокарта ATI R200……………………………………………………………...30

Шейдер……………………………………………………………………………...31

Выводы……………………………………………………………………………..33

Список использованной литературы …………………………………………….34

Что такое видеокарта?

Видеока́рта (известна также как графи́ческая пла́та, графи́ческая ка́рта, видеоада́птер, графический ада́птер) - устройство, преобразующее графический образ, хранящийся как содержимое памяти компьютера или самого адаптера, в иную форму, предназначенную для дальнейшего вывода на экран монитора. В настоящее время эта функция утратила основное значение и в первую очередь под графическим адаптером понимают устройство с графическим процессором - графический ускоритель, который и занимается формированием самого графического образа.

Видеопамять-один из компонентов компьютера, от которого требуется наибольшая производительность, это графический контроллер, являющийся сердцем всех мультимедиа систем.

Пропускная способность обычно измеряется в мегабайтах в секунду и показывает скорость, с которой происходит обмен данными между видеопамятью и графическим контроллером. На производительность графической подсистемы влияют несколько факторов: скорость центрального процессора,(CPU)скорость интерфейсной шины,(PCI или AGP)скорость видеопамяти, скорость графического контроллера

Современная видеокарта состоит из следующих частей :

Графический процессор(Graphics processing unit - графическое процессорное устройство) - занимается расчётами выводимого изображения, освобождая от этой обязанности центральный процессор, производит расчёты для обработки команд трёхмерной графики. Является основой графической платы, именно от него зависят быстродействие и возможности всего устройства.

Видеоконтроллер - отвечает за формирование изображения в видеопамяти, даёт команды RAMDAC на формирование сигналов развёртки для монитора и осуществляет обработку запросов центрального процессора. Кроме этого, обычно присутствуют контроллер внешней шины данных (например, PCI или AGP), контроллер внутренней шины данных и контроллер видеопамяти.

Видеопамять - выполняет роль кадрового буфера, в котором хранится изображение, генерируемое и постоянно изменяемое графическим процессором и выводимое на экран монитора (или нескольких мониторов). В видеопамяти хранятся также промежуточные невидимые на экране элементы изображения и другие данные. Видеопамять бывает нескольких типов, различающихся по скорости доступа и рабочей частоте. Современные видеокарты комплектуются памятью типа DDR, DDR2, GDDR3, GDDR4 и GDDR5.

Цифро-аналоговый преобразователь(ЦАП, RAMDAC - Random Access Memory Digital-to-Analog Converter) - служит для преобразования изображения, формируемого видеоконтроллером, в уровни интенсивности цвета, подаваемые на аналоговый монитор. Возможный диапазон цветности изображения определяется только параметрами RAMDAC. Чаще всего RAMDAC имеет четыре основных блока: три цифроаналоговых преобразователя, по одному на каждый цветовой канал (красный, зелёный, синий - RGB), и SRAM для хранения данных о гамма-коррекции

Видео-ПЗУ(Video ROM) - постоянное запоминающее устройство, в которое записаны видео-BIOS, экранные шрифты, служебные таблицы и т. п. ПЗУ не используется видеоконтроллером напрямую - к нему обращается только центральный процессор. Хранящийся в ПЗУ видео-BIOS обеспечивает инициализацию и работу видеокарты до загрузки основной операционной системы, а также содержит системные данные, которые могут читаться и интерпретироваться видеодрайвером в процессе работы (в зависимости от применяемого метода разделения ответственности между драйвером и BIOS). На многих современных картах устанавливаются электрически перепрограммируемые ПЗУ (EEPROM, Flash ROM), допускающие перезапись видео-BIOS самим пользователем при помощи специальной программы.

Система охлаждения - предназначена для сохранения температурного режима видеопроцессора и видеопамяти в допустимых пределах.

Правильная и полнофункциональная работа современного графического адаптера обеспечивается с помощью видеодрайвера - специального программного обеспечения, поставляемого производителем видеокарты и загружаемого в процессе запуска операционной системы. Видеодрайвер выполняет функции интерфейса между системой с запущенными в ней приложениями и видеоадаптером. Так же как и видео-BIOS, видеодрайвер организует и программно контролирует работу всех частей видеоадаптера через специальные регистры управления, доступ к которым происходит через соответствующую шину.

Ширина шины памяти, измеряется в битах - количество бит информации, передаваемой за такт. Важный параметр в производительности карты.

Объём видеопамяти, измеряется в мегабайтах - объём собственной оперативной памяти видеокарты. Больший объём далеко не всегда означает большую производительность.

Частоты ядра и памяти - измеряются в мегагерцах, чем больше, тем быстрее видеокарта будет обрабатывать информацию.

Текстурная и пиксельная скорость заполнения, измеряется в млн. пикселов в секунду, показывает количество выводимой информации в единицу времени.

выводы карты - видеоадаптеры MDA, Hercules, CGA и EGA оснащались 9-контактным разъёмом типа D-Sub. Изредка также присутствовал коаксиальный разъём Composite Video, позволяющий вывести черно-белое изображение на телевизионный приемник или монитор, оснащенный НЧ-видеовходом.

Для чего используется видеопамять?

Для чего нужны видеокарты и принципы их работы, знает множество продвинутых пользователей компьютера. Ну а историю их развития и усовершенствования от самого их появления до сегодняшнего дня мало кто знает.

Графические адаптеры, быть может, самые интересные и значимые составляющие современного ПК. Для огромного числа геймеров, видеокарты стоят на первом месте среди компонентов компьютера по значимости. Ради увеличения такого драгоценного количества кадров в игре они готовы выложить немалую сумму за лучшие видеокарты. А для разработчиков видеокарт эти денежные средства – толчок для создания более мощных и современных адаптеров. Развитие видеокарт существенно обгоняет развитие, например, процессоров. Хотя несколько десятков лет в это было трудно поверить.

Скорость, с которой информация поступает на экран, и количество информации, которое выходит из видеоадаптера и передается на экран - все зависит от трех факторов:

· разрешение вашего монитора

· количество цветов, из которых можно выбирать при создании изображения

· частота, с которой происходит обновление экрана

Разрешение определяется количеством пикселов на линии и количеством самих линий. Поэтому на дисплее с разрешением 1024х768, типичном для систем, использующих ОС Windows, изображение формируется каждый раз при обновлении экрана из 786,432 пикселов информации.

Обычно частота обновления экрана имеет значение не менее 75Hz, или циклов в секунду. Следствием мерцания экрана является зрительное напряжение и усталость глаз при длительном наблюдении за изображением. Для уменьшения усталости глаз и улучшения эргономичности изображения значение частоты обновления экрана должно быть достаточно высоким, не менее 75 Hz.

Число допускающих воспроизведение цветов, или глубина цвета - это десятичный эквивалент двоичного значения количества битов на пиксел. Так, 8 бит на пиксел эквивалентно 28 или 256 цветам, 16-битный цвет, часто называемый просто high-color, отображает более 65,000 цветов, а 24-битный цвет, также известный, как истинный или true color, может представить 16.7 миллионов цветов. 32-битный цвет с целью избежания путаницы обычно означает отображение истинного цвета с дополнительными 8 битами, которые используются для обеспечения 256 степеней прозрачности. Так, в 32-битном представлении каждый из 16.7 миллионов истинных цветов имеет дополнительные 256 степеней доступной прозрачности. Такие возможности представления цвета имеются только в системах высшего класса и графических рабочих станциях.

Ранее настольные компьютеры были оснащены в основном мониторами с диагональю экрана 14 дюймов. VGA разрешение 640х480 пикселов вполне и хорошо покрывало этот размер экрана. Как только размер среднего монитора увеличился до 15 дюймов, разрешение увеличилось до значения 800х600 пикселов. Так как компьютер все больше становится средством визуализации с постоянно улучшающейся графикой, а графический интерфейс пользователя (GUI) становится стандартом, пользователи хотят видеть больше информации на своих мониторах. Мониторы с диагональю 17 дюймов становятся стандартным оборудованием для систем на базе ОС Windows, и разрешение 1024х768 пикселов адекватно заполняет экран с таким размером. Некоторые пользователи используют разрешение 1280х1024 пикселов на 17 дюймовых мониторах.

Современной графической подсистеме для обеспечения разрешения 1024x768 требуется 1 Мегабайт памяти. Несмотря на то, что только три четверти этого объема памяти необходимо в действительности, графическая подсистема обычно хранит информацию о курсоре и ярлыках в буферной памяти дисплея (off-screen memory) для быстрого доступа. Пропускная способность памяти определяется соотношением того, как много мегабайт данных передаются в память и из нее за секунду времени. Типичное разрешение 1024х768, при 8-битной глубине представления цвета и частоте обновления экрана 75 Hz, требует пропускной способности памяти 1118 мегабайт в секунду. Добавление функций обработки 3D графики требует увеличения размера доступной памяти на борту видеоадаптера. В современных видеоакселераторах для систем на базе Windows типичен размер установленной памяти в 4 Мб. Дополнительная память сверх необходимой для создания изображения на экране используется для z-буфера и хранения текстур.

История видеокарт

Начало истории PC-совместимых персональных компьютеров положил адаптер MDA (Monochrome Display Adapter), появившийся во всем известном IBM в 1981 году и ставший родоначальником графических карт. Этот адаптер был первым неинтегрированным в материнскую плату. Он был собран на отдельной плате, и для него был создан специальной слот в универсальной шине XT-bus.

MDA - дальний предок современных видеокарт - IBM Monochrome Display Adapter

В принципе, он был видеоконтроллером, функция которого заключалась в выводе содержимого видеопамяти на монитор. Сигнал, который генерировал MDA, был цифровым, что явилось причиной отсутствия обязательного для последующих адаптеров RAMDAC. Плата MDA включала в себя не только чип видеоконтроллера, но и 4 кб видеопамяти, тактовый генератор и микросхему ПЗУ, в которой содержался шрифт.

Забавно, но адаптер MDA не работал в графическом режиме – он был просто текстовым. Однако, многие ПК в то время работали с графикой. Почему же IBM отказалось от графики? Заключалось все в позиции IBM. То, что компьютер умел «рисовать» на мониторе, тогда считалось чем-то несерьезным, связывалось с играми. И, конечно же, компьютеру для бизнеса не нужны были эти «игрушки».

Первый IBM PC

Но, несмотря на отсутствие графики, MDA умел достаточно. Он выводил на монитор 25 строк, содержащих 80 символов каждая, и отдельный символ располагался на матрице 9*14 пикселей. Таким образом, разрешение, выдаваемое MDA, было 720*350 пикселей, что придавало тексту большую четкость, которую конкуренты не предлагали. Помимо этого, у символов было 5 атрибутов на выбор: обычный, яркий, подчеркнутый, инверсный и даже мигающий. Очевидно, что работал MDA только с черно-белыми мониторами. А также у MDA был порт для принтера, что означало, что покупатели не надо было покупать дополнительный контроллер, который стоил в то время около $100.

И все же не будь у IBM PC графики – он не был бы таким популярным. Ради «несерьезных» пользователей для IBM PC в тот же год был изготовлен еще один адаптер, который назывался CGA (Color Graphics Adapter). Он был выпущен тоже в 1981 году. Он выдавал меньшее разрешение, чем у MDA, зато у него было гораздо больше режимов. Благодаря 16 кб видеопамяти, CGA мог работать и в текстовом режиме и в режиме графики.

Видеокарта IBM CGA

CGA отображал столько же строк и символов, сколько и MDA (25 по 80 или 40 символов). Однако, у символов было 16 цветов, хоть и располагались они на матрице 8*8 пикселей.

В графическом режиме CGA выводил изображение на экран в трех вариантах: 640*200 с цветом в 1 бит (монохром); 320*200 пикселей с 2 битами (4 цвета); 160*100 пикселей уже с цветом в 4 бита (16 различных цветов). Третий вариант технически был эмуляцией графики в текстовом режиме (происходила имитация пикселей при помощи наполовину закрашенной матрицы 8*8 пикселей).

Игры того времени - Solitare

Порт, передающий видеосигнал в цифре, у CGA был девятиконтактным, также как и порт у MDA, и у него был выход для работы с цветным телевизором. CGA работал с одноцветным дисплеем для MDA. И так было до 1984 года. До появления EGA адаптера.

Игры того времени - Wilf

Развитие видеокарт пошло по принципу роста количества цветов и пикселей в разрешении. Появившийся в 1984 году Enhanced Graphics Adapter (EGA) выводил на экран 16 цветов (4 бита) при разрешении в 640*350 пикселей. Видеопамять стала сперва 64 кб, а потом доросла до 256 кб, благодаря чему EGA справлялся с несколькими страницами памяти. По этой причине процессор формировал несколько кадров изображения сразу, т.е. получилось некое ускорение графики.

EGA - 16 цветов, 640х350 точек

Улучшение графики в EGA-играх - Yorick

Улучшенная графика - Ancient Art of War

Такие графические адаптеры не имели аналогов несколько лет, что в наши дни себе трудно вообразить. Это происходило до 1987 года, когда на ПК пользователи ставили наилучший для них адаптер – EGA. Но все же, в этом году появился другой, названный VGA (Video Graphics Array).

Этот адаптер был создан для новых ПК IBM PS/2. Проектируемое семейство должно было не использовать открытую архитектуру, и, к сожалению, оно было совершенно не успешным на рынке. Хотя и многие идеи этого семейства были приняты пользователями. Например, MCGA (Multi-Color Graphics Array), графический адаптер, который подключался к PS/2 компьютерам через системную плату, был изменен на плату для шины ISA. Это и есть VGA.

Разрешение у VGA было 640*480 пикселей и 16 цветами, либо 320*240 с 8-битным цветом (256 цветов). До фотореализма далековато, но все же шаг сделан. VGA получил новый интерфейс – 15-контактный D-Sub, который стал стандартом и сохранился даже до наших дней в некоторых ПК. Одной из особенностей была совместимость с приложениями для EGA, CGA и MDA, благодаря чему они работали на VGA.

Благодаря присутствию на борту адаптера 256 кб видеопамяти, VGA хранил по нескольку кадров, да еще и со шрифтом. Говорят, что когда использовался весь объем памяти, на экран можно было вывести кадр с разрешением 800*600 пикселей! Хотя это не подтверждено.

IBM VGA с новым интерфейсом

Слегка производительней

Как и в случае с предыдущими адаптерами для PS/2 IBM выпустила 2 адаптера: MCGA (VGA), который был строенным, а также продаваемый в качестве апгрейда 8514/А. Последний выводил изображение с разрешением 1024*768 точек и имел 8 бит цвета. К тому же создатели этого адаптера дополнили его еще некоторыми возможностями по ускорению графики, благодаря чему он выполнял часть функций по подготовке кадра.

8514/A рисовал линии, выполнял заливку части кадра, а также накладывал битовую маску и все это в своей видеопамяти. Это было существенным плюсом для приложений инженерной графике, ну а особенно это было заметно при создании диаграмм. Конечно же, нужна была помощь и от программ, которую они скоро и оказали.

Нельзя не отметить, что тогда графические станции профессионалов имели дополнительные сопроцессоры для графики, которые размещались на отдельных платах. Такие сопроцессоры были очень дорогостоящими и имели множество возможностей. Несмотря на ограниченную функциональность, 8514/A был намного дешевле, а это очень важный фактор для сферы ПК.

Игра Манджонг на 8514/A

Наступил 1990 год и появился XGA (Extended Graphics Array). Он сменил 8514/А и имел больше возможностей. Единственным изменением стал режим с разрешением 800*600 точек и 16 битами цвета (65 536 цветов, High Color). XGA положил начало доминированию различных адаптеров SuperVGA, а объемы видеопамяти и величина разрешения увеличивались год от года. Результатом этого стало то, что удивить качеством картинки покупателя становилось все сложнее. Соответственно, чтобы продавать новые дорогостоящие адаптеры, нужно было внедрять в них новые функции.

Старт 3D

Компанией-первооткрывателем 3D для компьютеров стала S3. Ее видеокарта S3 Virge поддерживала 4 Мб памяти VRAM или DRAM и стала наследником успеха Trio 64V+. Ядро и память обладали совсем смехотворной для наших дней частотой 80 МГц.

У этого адаптера появилась функция ускорения трехмерной графики. Благодаря этому создатели игр смогли пользоваться динамическим освещением и билинейной фильтрацией текстур, хоть и прибавку в скорости игр Virge не давала.

S3 Virge во всей красе

Компания быстро осознала, что ей, как первооткрывателю 3D, стоит внедрить свои платы в потребительский рынок. S3 стала заключать контракты с разработчиками Tomb Raider, Descent II, Mechwarrior 2, которые получили стандарт S3D. В S3 поняли, что необходимо распространять свой стандарт, получая тем самым, большее предпочтение покупателей, нежели другие производители. К функциям Virge можно, конечно, отнести поддержку OpenGL, однако производительность в использовании их была очень плохой. В функциях была заявлена даже поддержка Direct3D, несмотря на то, что почти все игры были для MS-DOS, и игры с Direct3D не были еще даже в планах.

Господство S3 на рынке видеоадаптеров длилось до 1996 года, когда появился ускоритель Voodoo Graphics от компании 3Dfx. И, несмотря на последующие обновления и улучшения, Virge так и остался всего лишь недорогой 2D-картой.

Сама 3Dfx появилась от понимания того, что для ПК необходима производительность в 3D, которая была хорошей в приставках того времени. Это поняли представители Silicon Graphics Гарри Таролли, Скотт Сеттерс и Росс Смит. Они и основали компанию.

Взяв кредиты, специалисты начали работу. Первые деньги и шаги в индустрии 3Dfx сделала на выпуске графических чипов для приставок того времени. А через год компания выпустила Voodoo Graphics. Новый адаптер был представлен на выставке Computex и вызвал огромный восторг. Такого плавного и красивого рендеринга 3D никто и не представлял. Качество графики было гораздо выше, нежели у Nintendo 64 и Playstation, которые только готовились выйти в свет. У Voodoo Graphics была заявлена поддержка и DirectX и OpenGL, хотя скорость была совсем небольшой. Но во время работы со своим интерфейсом, названным Glide, работало все очень хорошо. Разработчики игр тут же начали оптимизацию под Voodoo Graphics, не задумываясь о ее конкурентах. Выдаваемый адаптером режим разрешением в 640*480 точек и 16 бит цвета сейчас не удивляет совершенно, но в то время это для потребителей было даже впечатляюще.

Возможности Glide

Сам адаптер устанавливался в специальный слот PCI, однако не имел функций 2D. Принцип работы состоял в перехвате управления в режиме 3D у обычного адаптера, через который он и подключался к монитору. Совмещение качественных 2D и 3D адаптеров сначала выглядело очень интересным и пользовалось популярностью пользователей. В том же году вышел 3D-ускоритель Rendition Verite V1000, у которого были функции 2D-видеокарты, однако при высоком разрешении он затуманивал изображение. Из-за этого также не пользовался популярностью Voodoo Rush, который вышел годом позже и был полноценной видеокартой с 3D-ядром Voodoo Graphics.

Видеокарта Voodoo Graphics

У Voodoo Graphics было 3 Мб EDO DRAM, которая работала на частоте 50 МГц, аналогичной процессору. На исходе 1996 года произошло падение цен на EDO DRAM и 3Dfx начало продавать адаптеры относительно дешево, вызывая тем самым всплески своей популярности у потребителей. Однако собственных адаптеров 3Dfx не реализовывала. Она была поставщиком их для партнеров. Самым популярным был Diamond Monster 3D, благодаря которому товары 3Dfx стали называться «монстрами».

Видеокарта Diamond Monster - на вид не такой уж и монстр

Опытные конкуренты

Легендарный Quake на Riva128

Но 3Dfx не была единоличным владельцем рынка. Появившаяся еще в 1985 году компания ATI, начав с «клонирования» IBM 8514/A, имела опыт и достаточную известность к появлению первого адаптера от 3Dfx. К 1995 году у нее был уже Rage адаптер, который выдавал отличную 2D картинку, имел возможности 3D и мог обрабатывать сжатый видеопоток MPEG-1. Выпуск 3D Rage II произошел в середине 1996 года. Этот ускоритель был в 2 раза быстрее предшественника и обрабатывал уже формат MPEG-2 (DVD). У ускорителя была поддержка Direct3D и OpenGL (частично). На борту он нес 8 Мб SDRAM, а процессор и память имели частоту 60 и 83 МГц соответственно. Несмотря на заметный недостаток в производительности в 3D-рендеринге, карта имела отличное 2D-изображение и могла аппаратно ускорять видео на начальном уровне.

Появившаяся на пару лет раньше 3Dfx, компания NVIDIA в 1995 году выпустила свой первый, хоть и провальный, продукт NV1. Он совмещал 3D-ускоритель, 2D-адаптер, а также адаптер звука и порт для геймпада Sega Saturn. Он был дорогим, и архитектура была у него странная: 3D появлялось из кривых третьего порядка, а не из полигонов. Для создателей игр этот подход был слишком оригинален и сулил немало трудностей в создании движка для игры. Ну а когда появился Direct3D, NV1 окончательно канул в лету.

Несмотря на это и на потери в сотрудниках и деньгах, NVIDIA смогла выпустить совсем другой продукт, названный NVIDIA Riva 128, базировавшийся на чипе NV3 и имевший 4 Мб (а в версии 128ZX - 8мб) SDRAM, шину в 128 бит и рабочую частоту в 100 МГц. Производительность в 3D у него была на уровне Voodoo Graphics, и выпускался он в 2 вариантах: PCI и AGP, который не поддерживали продукты 3Dfx. Riva 128 помог NVIDIA не стать банкротом. Однако, ничья у 3Dfx и NVIDIA была всего лишь в непопулярном в то время Direct3D.

То, что на рынке появлялись все более новые и совершенные 3D-игры и видеоплаты, послужило поводом создания более совершенных и быстрых видеокарт. Вехой истории видеокарт был 1998 год, который стал годом рождения адаптера Voodoo2, обладавшего 8 или 12 Мб памяти EDO DRAM на борту и работавший на частоте в 100 МГц.

Voodoo2 с первым в мире SLI

Архитектура Voodoo2 была практически такая же, как и в Voodoo за исключением нескольких особенностей. Первой особенностью являлся дополнительный текстурный блок, с помощью которого за 1 проход рендеринга можно было накладывать до двух текстур за проход, что гораздо увеличило производительность. Вторая особенность – картинка, выводимая адаптером. Разрешение картинки достигало 1024*768 пикселей при 12 Мб памяти и 800*600 в случае с 8 Мб памяти при режиме цвета в 16 бит. Но главное инновацией был режим SLI, который позволял совместно работать сразу двум Voodoo2. Эта система была очень и очень дорогостоящей, однако аналогов у фирм-конкурентов не было и в помине, а производительность была невероятной.

Мощнейшая конструкция: две Voodoo2 в режиме SLI

В этом году NVIDIA не смогла нагнать 3Dfx, но появившаяся в том году Riva TNT (NV4) стала толчком к успеху компании. За 2 года специалисты NVIDIA создали новую архитектуру, которая дала RIVA TNT 2 конвейера для рендеринга, то есть она так же, как и Voodoo2 накладывала 2 текстуры за проход. RIVA TNT работала на частоте 90 МГц, а память у нее была SDRAM, объем которой был 16 Мб.

RIVA TNT от NVIDIA

Глубина цвета у продукта NVIDIA была 32 бита, однако производительность при этом режиме уменьшалась аж в 2 раза, что было негативно встречено покупателями. Несмотря на это RIVA TNT положила начало рендерингу в 32-битном цвете, и вскоре появились модели, которые давали приемлемую производительность в этом режиме. Еще у RIVA TNT была возможность работы с текстурами 1024*1024 пикселей, а для Voodoo2 максимумом были текстуры размером 256*256 точек.

Развитие в те годы библиотеки Glide от 3Dfx было серьезной проблемой для NVIDIA, помощь в решении которой оказывала, сама того не зная, Microsoft, активно распространявшая Direct3D.

Компания ATI пыталась не отставать от своих конкурентов и выпустила в 1998 году свою 3D Rage Pro, которая не имела особого успеха и преимущества перед конкурентами. Единственное, чем могла похвастаться эта видеокарта, так это производительность при обработке сжатого потока DVD. Производительность в 3D у этого продукта была не лучше видеокарт предыдущего поколения, а поддержка OpenGL была всего лишь «для галочки». По этим причинам 3D Rage Pro почти никак не была оценена потребителями и стала всего лишь хорошим 2D-адаптером.

К слову о 2D . В те годы было множество производителей 2D-адаптеров, лидером среди которых была фирма Matrox, которая представила в 1998 году свой адаптер, предназначенный как для 2D, так и для 3D. Этот чип полностью поддерживал 3D-рендеринг и мог держать конкуренцию с Riva TNT от NVIDIA в плане производительности.

G200 обладал великолепной производительностью в 2D, и, помимо этого, обеспечивал высокое качество рендеринга в 3D при 16 и 32 битах цвета. Рабочей частотой для G200 являлись от 84 до 90 МГц, он оснащался двумя шинами данных в 64 бита каждая. Обеспечивая такую же пропускную способность, данное решение давало меньше латентности по сравнению с обычной 128-битной шиной. К тому же, благодаря технологии DIME, адаптер мог хранить текстуры с разрешением до 2048*2048 пикселей в системной памяти, а это решение дало возможность остановиться на объеме видеопамяти в 8 Мб, что помогло продукту стать дешевле.

3D Rage Pro с разъемом для дополнительно подключаемой памяти

На закате 90-х лидерами производства видеокарт были 3Dfx, занимавшая прочное первое место, за ним следовала NVIDIA, ну а далее их пыталась догнать толпа других производителей (среди которых выделялись ATI, Matrox и S3), которые на то время были статистами. Определяющим стал 1999 год.

В начале года были анонсированы Voodoo3, G400, Rage 128 и Riva TNT2. Рабочая частота у детища 3Dfx была 183 МГц и этот адаптер поддерживал SLI. Однако технологические новинки обошли стороной адаптер от 3Dfx, у которого были возможности 2D-адаптеров, однако у него был всего один конвейер для рендеринга и он не поддерживал 32 бита цвета и текстуры большого разрешение.

Voodoo 3 от 3Dfx

Ответом от NVIDIA стал чип NV5, устанавливавшийся в TNT2. Главным для NVIDIA было соответствие технологической новизне. Таким образом Riva TNT2 первой получила поддержку AGP 4x, обеспечивала неплохую производительность рендеринга при 32 битах цвета, а работала она на частоте до 150 МГц и 183 МГц для памяти. На то время TNT2 была полностью конкурентоспособным соперником для Voodoo3. Таким образом, безоговорочное лидерство 3Dfx на данном этапе истории видеокарт оказалось под сомнением.

Не отставать от гигантов смогла и Matrox, выпустившая G400. Технологии компании, которые были внедрены в чип G200, получили развитие. У G200 были две шины в 128 бит каждая, частотой в 125-150 МГц, и шину памяти в 128 бит с частотой 166-200 МГц. Новинкой стала технология EMBM (Environment mapped Bump mapping), которая стала аппаратной поддержкой эффектов рельефности текстур. Благодаря ей графика вышла на принципиально новый уровень.

Matrox Millenium G400MAX и ее два разъема для подключения мониторов

Представление технологии EMBM

Ко всему прочему у G400 впервые появилась поддержка двух мониторов. Таким образом G400 смогла на время выйти на первое место среди видеокарт. К сожалению, G400 теряла производительность в работе с OpenGL играми, а большинство игр того времени не поддерживали Direct3D.

ATI, все еще отстававшая от лидеров, выпустила достаточно интересный для геймеров Rage 128. Он был гораздо дешевле новинок от NVIDIA и 3Dfx, однако скорость рендеринга при 32 битах цвета была выше RivaTNT, а также чип получил поддержку OpenGL и Direct3D. Таким образом дела у ATI пошли гораздо лучше.

Небольшой рывок от ATI: их Rage 128

К концу 1999 года наступил еще один этап противостояния лидеров производства видеокарт. 3Dfx запустил VSA-100, который должен был исправить отставания в технологическом плане, NVIDIA готовила NV10, обещавший стать «сюрпризом», а ATI и S3 пытались прорваться на передовые позиции своими Rage Fury MAXX и Savage 2000 соответственно. Что же предлагали пользователям эти компании?

VSA-100 обладала технологией T-Buffer, которая обеспечивала постобработку изображения использующую кинематографические спецэффекты. Полноэкранное сглаживание (Full-scene Anti-aliasing), размытие в движении (Motion Blur), глубина резкости (Depth Of Field) и мягкие тени (Soft Shadows) должны были улучшить качество картинки без падения производительности.

Преимуществом NVIDIA стала технология расчета трансформации и освещения (Transform and Lighting, T&L). С использованием этой технологии с центрального процессора снималась часть задач по расчету вершин треугольников, обеспечивая тем самым прирост производительности в играх.

ATI Rage Fury MAXX был по сути своей соединением двух Rage 128 Pro на одной плате, которые формировали кадры по очереди. Стоимость должна была стать огромной.

Слишком дорогая ATI Rage Fury MAXX

S3 Savage 2000 обладал T&L, как и продукт NVIDIA, у него была передовая технология сжатия текстур. Этот адаптер планировался как дешевая, более технологичная альтернатива Voodoo3, способная вытеснить NVIDIA на второй план.

На деле же все оказалось совсем не так. 3Dfx не успела выпустить свои Voodoo4, Voodoo5 и Voodoo6 до лета 2000 года. А вот NVIDIA смогла к тому времени вывести в свет свой NV15, который был гораздо мощнее Voodoo6. Voodoo 4 и Voodoo5, обладавшие одним чипом серьезно проигрывали конкурентам в плане производительности, а двух- и четырехчиповые Voodoo5 были дорогостоящими и изрядно грелись. Это явилось ударом для 3Dfx, которая не так давно была флагманом производства видеокарт. Потерю лидирующей позиции сразу заметили кредиторы.

Шумный и совсем не быстрый Voodoo5 с 4 чипами

Выход Savage 2000 от S3 состоялся немного позднее. T&L и сжатие текстур на самом деле хорошо работали и давали увеличение производительности, но только при поддержке этих технологий приложениями. Таким образом при отсутствии данной поддержке Savage 2000 серьезно проигрывал конкурентам, а S3 совершенно не интересовал создателей игр. Помимо прочего, у этого продукта были большие проблемы с установкой драйверов, а также со сравнительно низкой производительностью блока T&L. Несмотря на это, технология S3TC, которая занималась сжатием текстур, заинтересовала компанию Microsoft, и они выкупили ее и лицензировали под названием DXTC. Соответственно, видеокарты всех компаний смогли получить эту технологию.

Адаптер от ATI в целом стал удачным решением, но не для своей цены. К тому же для него было очень сложно написать драйвер, который программисты ATI смогли выпустить лишь через несколько месяцев после того, как появился сам адаптер.

Лучше всех стал адаптер NVIDIA. GeForce 256 смог опередить все другие адаптеры за счет отличной функциональности. У него было четыре конвейера рендеринга, рабочая частота 120 МГц и 32 Мб памяти (с частотой 166 МГц и 128-битной шиной) SDRAM (которая с 2000 года стала DDR SDRAM). Не забыли в NVIDIDA и про T&L, который начинали поддерживать все выходящие игры.

Великолепная GeForce 256

К сожалению, свой штрих в этот этап истории видеокарт не смогла вписать Matrox. Они не последовали принципу выпуска новых адаптеров каждые 6 месяцев, а G400 проигрывал GeForce из-за плохой производительности в OpenGL, а также пресловутого T&L. Так, G400 стал востребованным лишь теми, кому нужно было использовать для работы или игры 2 монитора. У Matrox просто-напросто кончились идеи.

Пара слов о TRUFORM

Различие карт бюджетного класса и карт топ-класса крайне сильно заметно. Один из самых главных показателей этого – сумма треугольников в кадре. Чем она выше, тем мощнее видеокарта и понадобится. А что касается создателей игр? Зачем создавать много различно детализированных моделей в зависимости от уровня видеокарты? С ответом помогли в ATI созданием TruForm.

Тот чип, который поддерживает эту технологию, может изменять как полигональные объекты в линейные, так и обратно. В итоге, модели получают плавность выше задуманной.

Единственным минусом становится то, что технологии просто необходимо присутствие маркеров, которые указывают то, чем, где и как можно усложнить модель и сделать ее плавнее. А вот без этих маркеров будут артефакты, такие как кубы, ставшие шарами и т.д. А без поддержки создателей продукта с 3D-графикой от этих артефактов никак не избавиться…

Борьба передовиков

Все шло к тому, что NVIDIA единолично возглавит рынок. Она купила банкротов 3Dfx с ее работниками и разработками, созданный NVIDIA чип NV15 стал хорошей модернизацией чипов NV10, а дешевые версии ее чипов заняли весь рынок, вытеснив конкурентов.

Но ATI доказала NVIDIA свою полную конкурентоспособность. В июне 2000 года они выпустили ATI Radeon, у которого было 64 Мб DDR SDRAM с шиной 128 бит, и он работал на частоте 183 МГц. Как и у адаптера NVIDIA, у Radeon был блок T&L, тем самым ATI показала и доказала потребителям то, что у компаний нет никакого технологического разрыва. К тому же их продукт оказался дешевле.

Однако, в Matrox пока не отчаивались. Они выпустили G450, являвшийся более совершенной версией G400 и был создан с использованием новых технологических норм (180 против 250 нм в сравнении с G400), а память была более быстрая, однако на 64-разрядной шине, что не изменяло скорость обмена с памятью. В теории то, что у G400 был использован новый техпроцесс, должно было увеличить тактовую частоту чипа, чего не произошло. В итоге G450 разочаровал геймеров, и Matrox догнать ATI и NVIDIA не смогла.

Видеопамять - одна из технических характеристик графической платы (видеокарты). Она хранит данные, которые требуются для воспроизведения изображения на мониторе. Если видеопамяти недостаточно, снижается качество графики и может зависать или некорректно отображаться трансляция. Чтобы решить эти проблемы, попробуйте увеличить объем оперативной памяти графической карты. Но это не поможет повысить производительность при недостаточной пропускной способности шины видеокарты.

Чтобы разобраться, как увеличить видеопамять на компьютере или ноутбуке, выясним, какая графическая карта в него установлена. От вида адаптера зависит, каким способом повышается его объем. В легких портативных гаджетах (нетбуках, ультрабуках) обычно встроены компактные внутренние (интегрированные) видеоадаптеры. Ими же производители комплектуют бюджетные ноутбуки. О наличии именно такой платы свидетельствует совместное расположение разъемов HDMI, LAN, USB. В мощные игровые ноутбуки и десктопные ПК устанавливаются внешние (дискретные) графические адаптеры. Они массивные и производительные, имеют собственную систему охлаждения. Если видеопамять интегрированной платы распределяется по технологии “Shared memory”, то ее объем меняется вручную. В таком случае проще всего воспользоваться встроенными в операционную систему инструментами. Проверьте, установлен ли Catalyst Control Center в вашей версии ОС. Для этого зайдите в «Панель управления» → «Оборудование и звук», в разделе «Устройства и принтеры» выберите «Диспетчер устройств». В нем перечислены все устройства, подключенные к компьютеру. Информация о графической карте находится в пункте «Видеоадаптеры». Некоторые модели компьютеров имеют больше одной видеоплаты. Нажмите правой клавишей мыши на интересующий вас адаптер и выберите из выпадающего меню раздел «Свойства». Во вкладке «Драйвера» есть пункт «Буфер кадра» или «Кадровый буфер UMA». В нем выставляется максимальный объем памяти, который станет доступным для видеоплаты. Если по указанному пути нет кадрового буфера, изменять текущие параметры UMA придется . Когда вы войдёте в базовую систему ввода-вывода, найдите раздел «Интегрированные устройства», а в нем настройки “BIOS VGA sharing memory”. Название может немного отличаться в зависимости от версии BIOS и модели компьютера. Далее выберите подходящее значение объема. Максимальное выставлять не рекомендуется, попробуйте поставить вдвое большее, чем указано по умолчанию. Затем сохраните изменения и покиньте BIOS.

При изменении параметров работы видеокарты соблюдайте осторожность. Слишком высокая нагрузка может вывести ее из строя. Обратите внимание, что увеличение производительности встроенной видеокарты происходит за счет оперативной памяти. Если ее недостаточно, работа компьютера замедлится. Старую дискретную карту почти невозможно «разогнать». Если ваши усилия не привели к удовлетворительным результатам, устаревшие комплектующие остается только заменить.